In erster Linie möchte hier betonen, dass dies keine bezahlte Werbung darstellt.

Ich bekomme von keinen der genannten Firmen Geld oder werde sonst unterstützt. Das alles sind selbst erstellte private Arbeiten.

Update April 2024

Update Mai 2024

Update JUNI 2025

August 2022:

Das ganze Prozedere wie ich nun Bilder erstelle, hat sich gerade 180 Grad gedreht. Ich nutze nicht mehr „Set a Light“ als Hauptool, weil es mich leider nicht mehr weiter bringt. Ich habe mich seit August 2022, mit der Erstellung von Bilder mit einer KI beschäftigt. Die ersten Ergebnisse waren nicht wirklich berauschend und auch nicht reif. Das hat sich mittlerweile schlagartig geändert. Ich würde sogar sagen, dass die Qualität der erstellten Bilder nun so weit ist, dass eine Erkennung, ob es sich um ein Foto oder doch ein gerendertes Bild handelt, nur noch sehr schwer erkennbar wird. Die KI tut sich mit Händen und Fingern leider sehr schwer. Was mittlerweile aber auch immer besser wird. Manchmal hat eine Figur plötzlich 6 oder 7 Finger. Oder der Arm verschwindet plötzlich am Hals. Das liegt aber dann an der unglaublichen Komplexität des Tools. Ich rede hier von StableDiffusion. Das ist das Tool schlecht hin für Bilderstellung/Retusche und andere fantastischen Dingen die man damit erstellen kann. Eine Retusche ala Photoshop ist damit Geschichte. Vorbei sind die Zeiten von Stempel und Clone Werkzeugen. https://de.wikipedia.org/wiki/Stable_Diffusion

Einen Erklärung wie das Tool funktioniert oder wie man es installiert, überlasse ich den Profis. Einfach danach im Netz suchen. Es gibt unglaublich viel Information mittlerweile im Netz dazu. In diesem Sinne, viel Spaß auf meiner Seite.

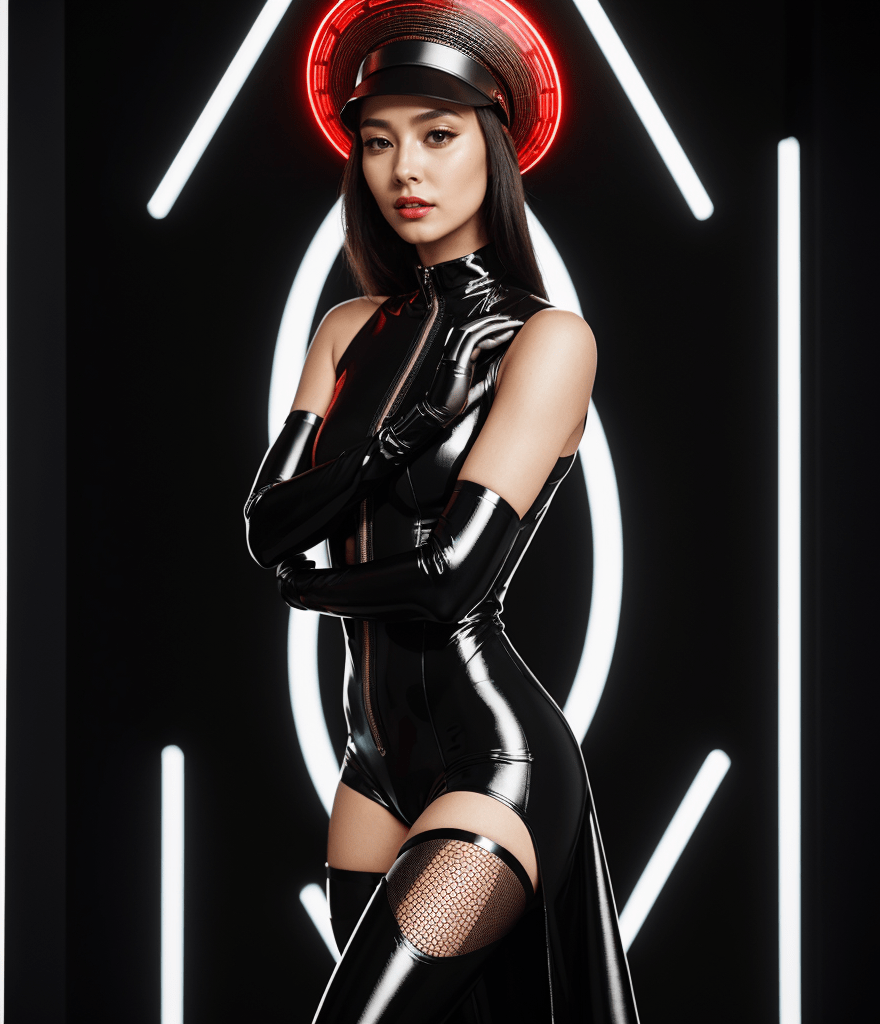

Der „Frauen-Cyborg“ wurde mit Stable Diffusion auf meinem Linux-System erstellt (Renderzeit ca.9 Min). Leider ist hierfür eine sehr schnelle Grafikkarte mit viel Speicher nötig, weil das System direkt am Rechner läuft. Es geht zwar auch mit kleineren bzw. älteren Grafikkarten, aber das dauert dann leider auch wie bei mir, dementsprechend lange. Die KI im allgemeinen kann aber noch mehr…Eine kleine Begrüßung des Cyborg gibt es hier. (demnächst hier mehr zum Thema) 🙂

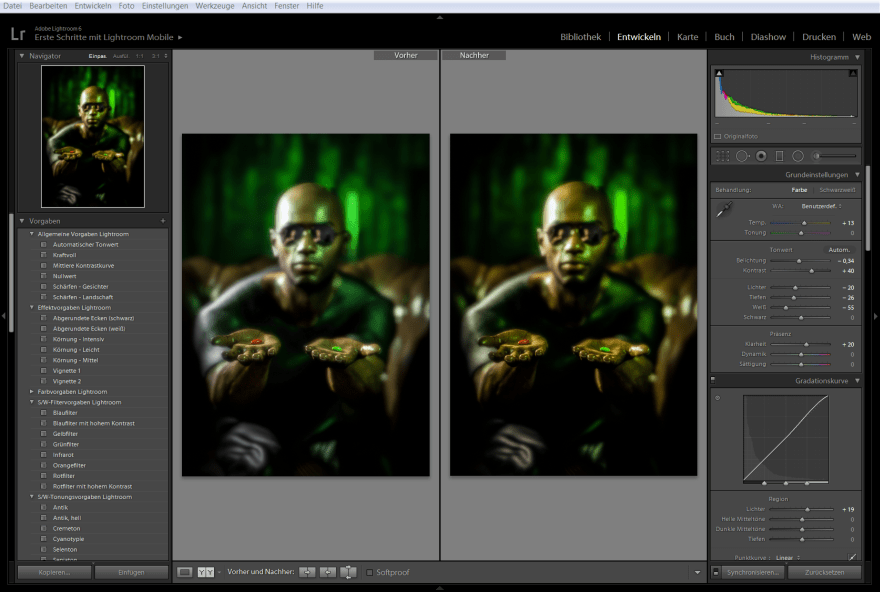

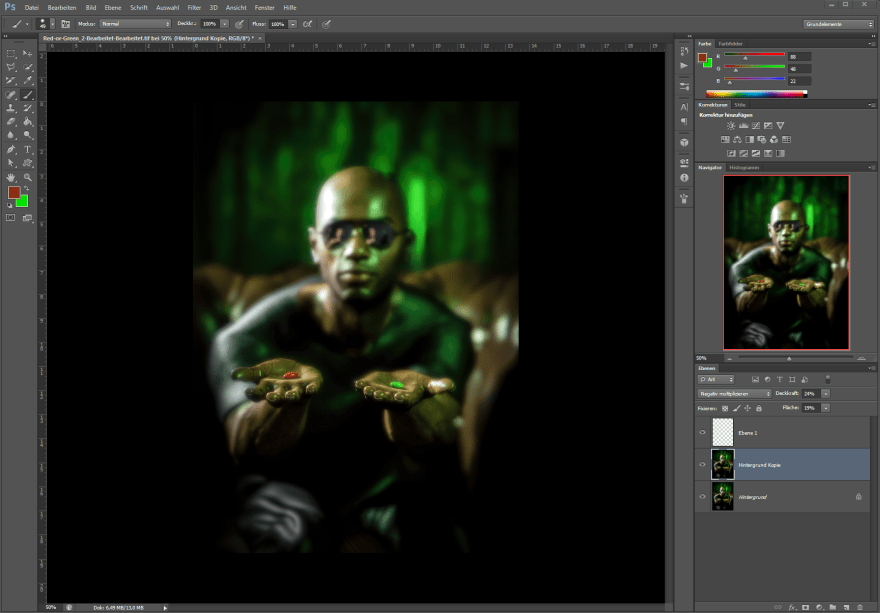

Dies war noch der alte Ablauf über „Set a Light 3D“…

Die Schwebende Person (NEO) reflektiert sich z.B. in der Sonnenbrille von Morpheus. Stimmt das soweit, wird das Bild gerendert. Hier wird nur eine Vorschau angezeigt. Das Rendern dauert je nach Rechnerpower einige Minuten. Dieses Bild wird dann in meinem Fall in Lightroom geladen und dort werden die Kontraste, Tiefen, Klarheit, Dynamik, Sättigung und die Belichtung noch einmal bearbeitet.

Ist dies passiert, wird das Bild erneut exportiert. Diesmal in Photoshop.

Da mir die Hauttöne nicht immer passen, wird in PS weiter an den Farben gearbeitet. Der Vorteil ist hier, die unendliche Möglichkeit Layer über Layer zu legen und zu Multiplizieren oder andere Effekte mit einzubinden. Der Vorgang bis zum finalen Bild hatte dann schon mehrer Stunden gedauert.

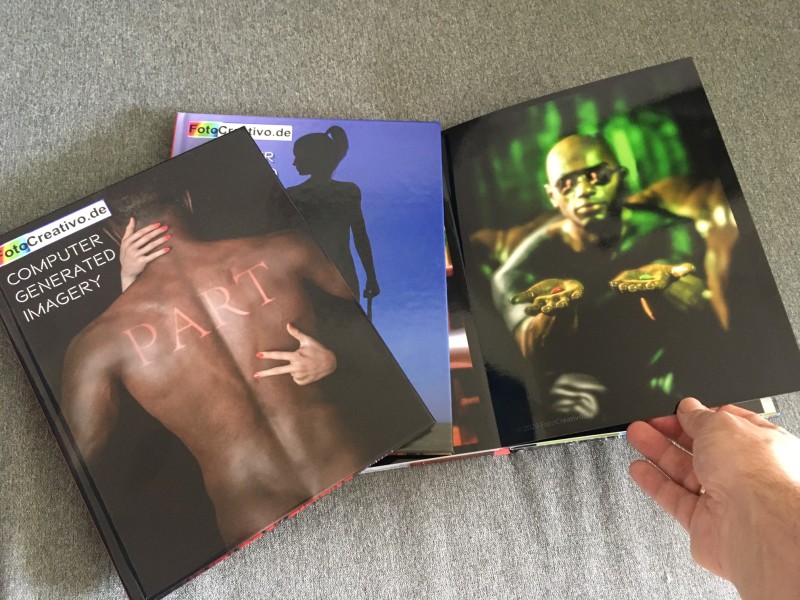

Das fertige Bild in diesem Fall das 29. Bild im zweiten Buch in DIN A4 Größe.

In einem Buch werden die dunklen Bereiche oft zu dunkel gedruckt, deshalb habe ich

dieses Bild, dann auch etwas heller in der Software für das Buch gesetzt. Dies ist kein Fehler der Software, sondern eine Option die man setzten kann. Mit dem Ergebnis bin ich auch sehr zufrieden. Die Seiten sind sehr dick, fast eigentlich schon Karton Stärke.

Bis jetzt sind es schon 15 fertige Bücher, mit über 1000 CGI-Bilder geworden. Das 16.Buch füllt sich langsam aber sicher.

Ich nutze jetzt meine erstellen Bilder, die ich mit dem traditionellen 3d Tool erstellte und übergebe diese Bilddaten an die KI und es kommen dann Fotos heraus, die einfach unglaublich sind.Die richtigen Einstellungen und der Prompt (txt2image) ist hier ausschlaggebend. Es kann genauso den Gesichtsausdruck, über einen Wert angegeben werden z.B. (smile.0.8). Hier gibt es nicht richtig oder falsch. Es muss einfach getestet werden ob das Bild passt, dass man so sehen möchte. Hat man ein Referenzbild erstellt, kann man dies nutzen und praktisch unendliche verschiedene Gesichter erstellen.

Auch wenn sie nicht 100% perfekt sind. Wirken die KI-Bilder doch schon realistischer als die ursprünglichen berechneten Bilder. Spaß mit der KI: Ich als Superheld…:-) Als Referenzbild für die KI erstellen Bilder, nutze ich nur ein einziges Bild von mir! Dieses Bild von mir hatte ich für die Berechnungen genutzt. Der Mund ist auf diesem Bild geschlossen, doch die KI macht auch ein Lächeln nicht unmöglich. Von den Haaren wollen wir erst garnicht anfangen…:-)))

Wie bei diesem Bild, dass ich anschließen in die KI exportiert habe, wurde ein Faceswap bei der Neuberechnung angewandt. Hier habe ich wiederum ein altes 3d Bild (geschlossenen Augen, offener Mund) das ich ursprünglich herkömmlich über Set a Light erstellt habe, um es dann auf die KI-Version zu rendern lassen. Dadurch ist dieses Bild absolut unrealistisch und nicht mit einer echten lebenden Person zu verwechseln, auch wenn es tatsächlich so wirkt.

Update Dezember 2023:

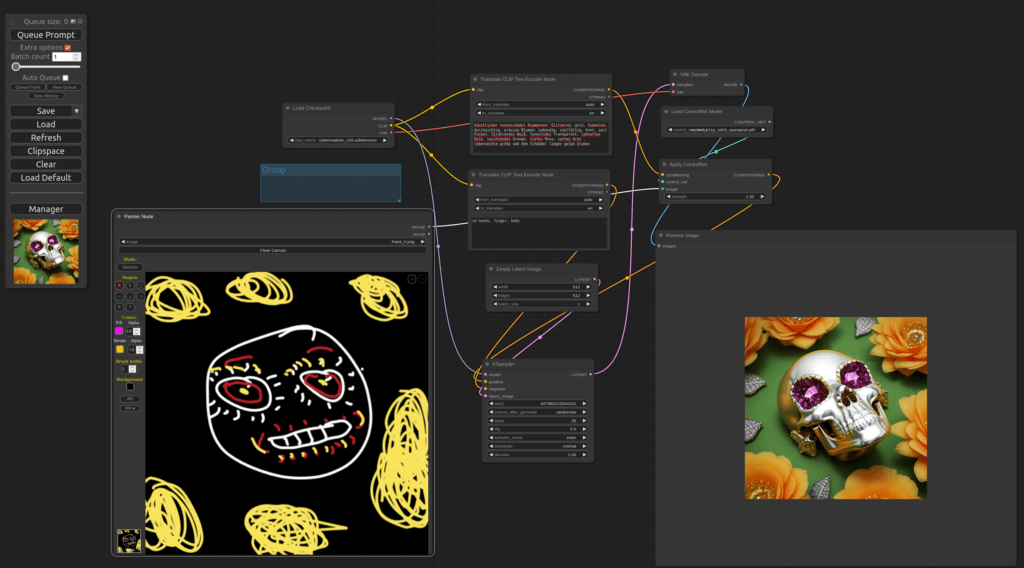

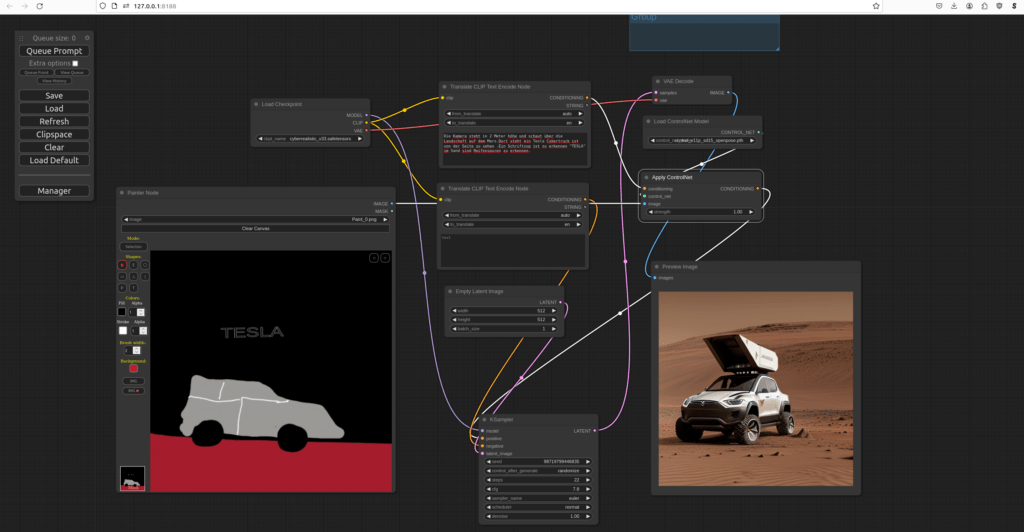

Im Moment nutze ich eine andere Möglichkeit, KI geränderte Bilder zu erzeugen.

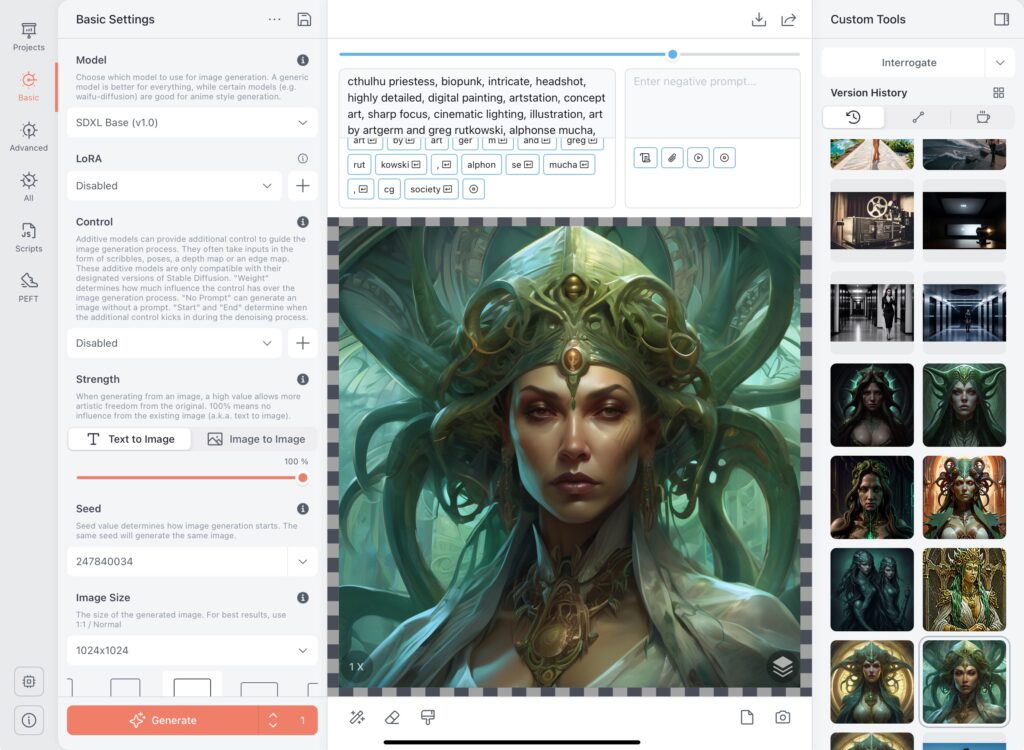

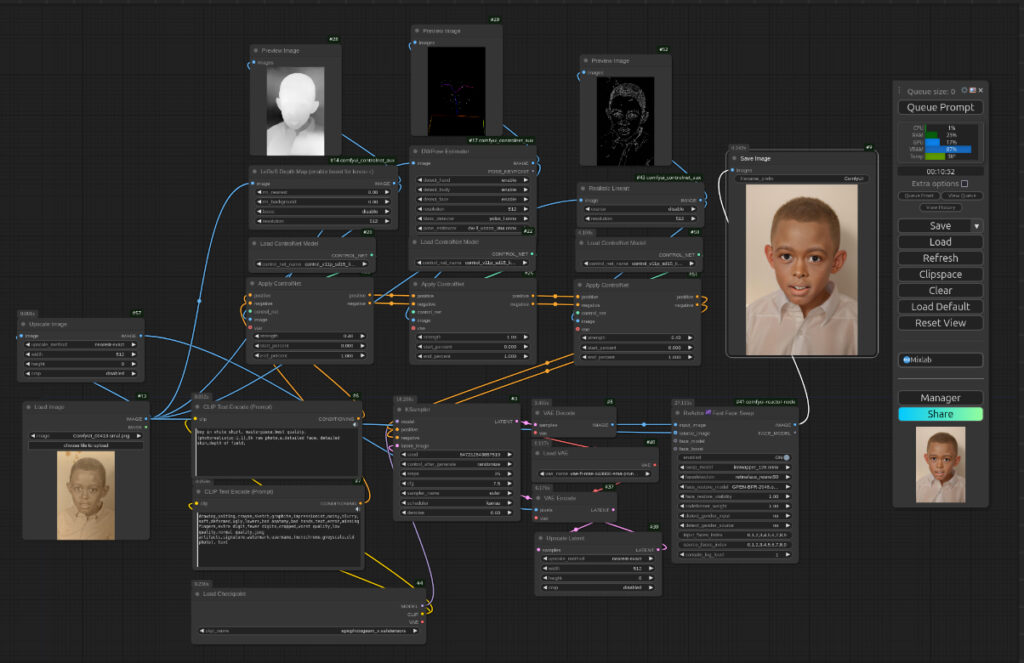

Die Benutzeroberfläche, aber auch die Art und Weise wie man nun vorgeht, ist noch effektiver und schneller. Ich nutze ComfyUI-in Verbindung mit Stable Diffusion die man über Gihub installieren kann. Diese GUI ist so effektiv und auch so komplex, dass man in der Tat erst einmal verstehen muss was hier passiert. Sie müssen sich vorstellen, sie haben eine Idee für ein Bild. Wie kann ich das einer KI vermitteln? Mit ComfyUI ist das möglich, in Echtzeit etwas zu skizzieren und (sofern die Grafikkarte schnell genug ist) dies auch fast in Echtzeit auf dem Bildschirm zu generieren. Das folgende Screenshot zeigt es deutlich:

Es ist eigentlich nicht zu glauben, dass die KI mein Gekritzel auch nur annähernd erkannt haben kann. Es müssen im Prompt erklärt werden was ich mit dem gekritzeltem Pizzagesicht sagen möchte. Das ganze geht im Moment bis 1024*1024. Optimal sind aber 512*512 Pixel.

Das ist aber kein Problem, weil es auch wiederum die Möglichkeit gibt das fertige Bild zu skalieren. Also nicht einfach hochziehen, weil dann würde es unscharf werden würde, sondern auf die Größe umzurechnen. Das dauert dann je nach Grafikkarte (GPU) 2-3 Minuten bis zu 30 Minuten! (CPU), aber dafür hat man dann ein Bild mit einer Kantenlänge von 2000*2000 Pixel. Die Qualität kann sich sehen lassen!

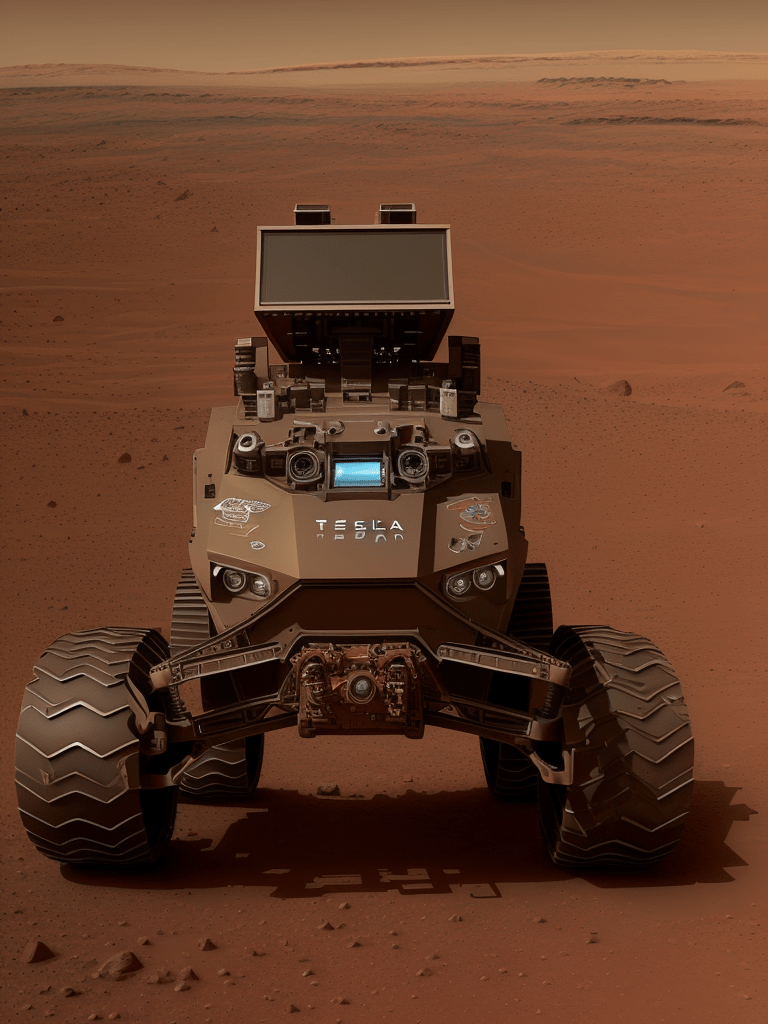

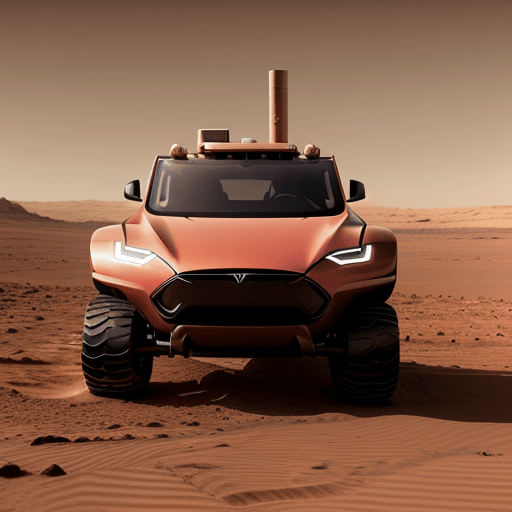

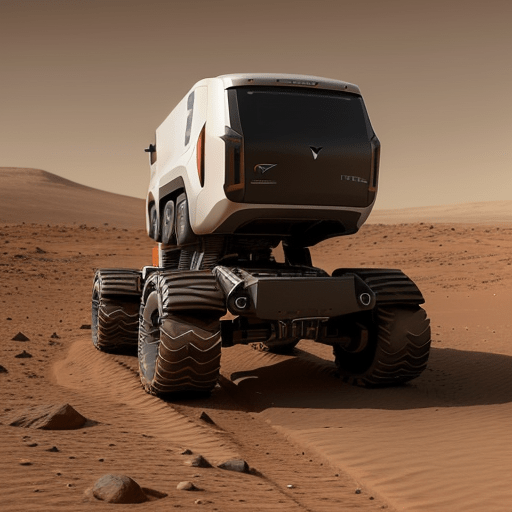

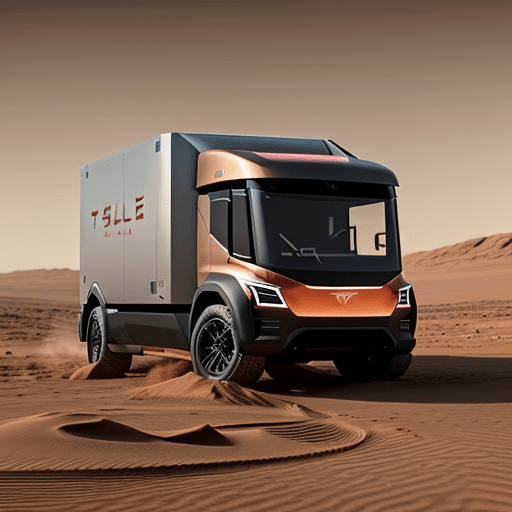

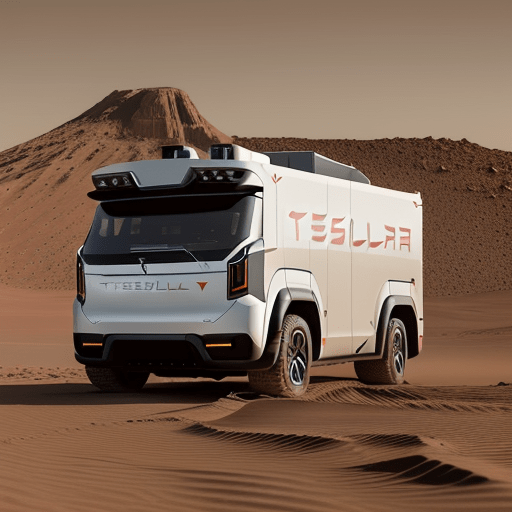

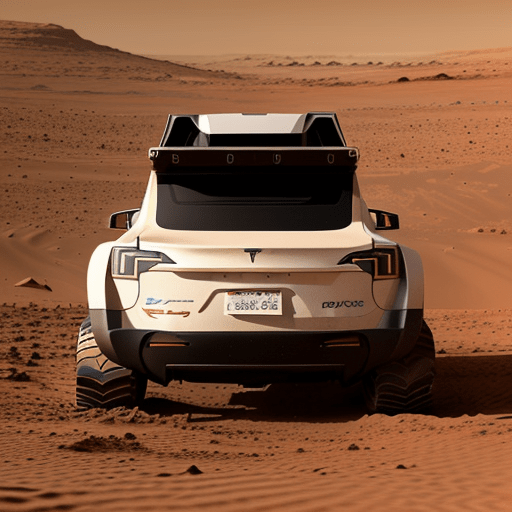

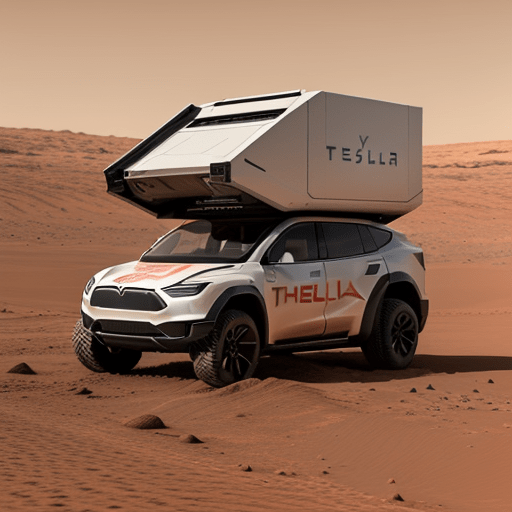

Dann fragte ich die KI nach der Möglichkeit, was wäre wenn Tesla auf dem Mars wäre. Wie würden denn die Autos auf dem Mars aussehen. Also skizzierte ich ein gekritzelte etwas mit einem passenden Prompt. Und heraus gekommen sind diese Auto, die von der KI dann in diversen Variationen hergestellt worden sind. Nur zum Verständnis, diese Bilder existieren so nicht!

(Die Bilder sind jetzt auch relativ stark komprimiert)

Update 27.12.2023

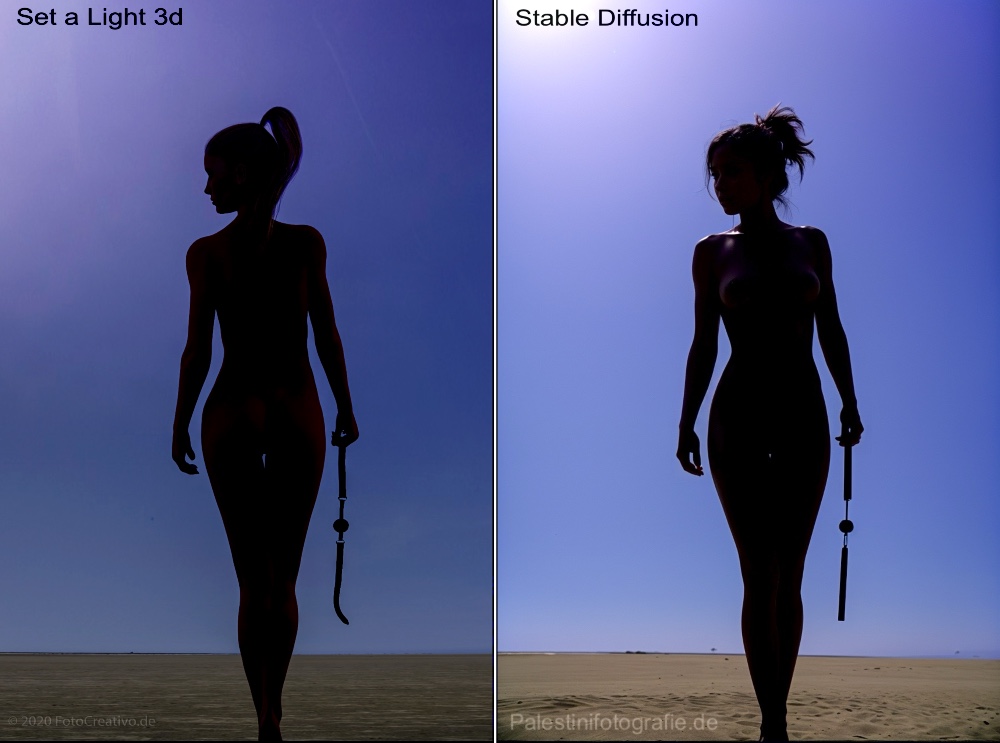

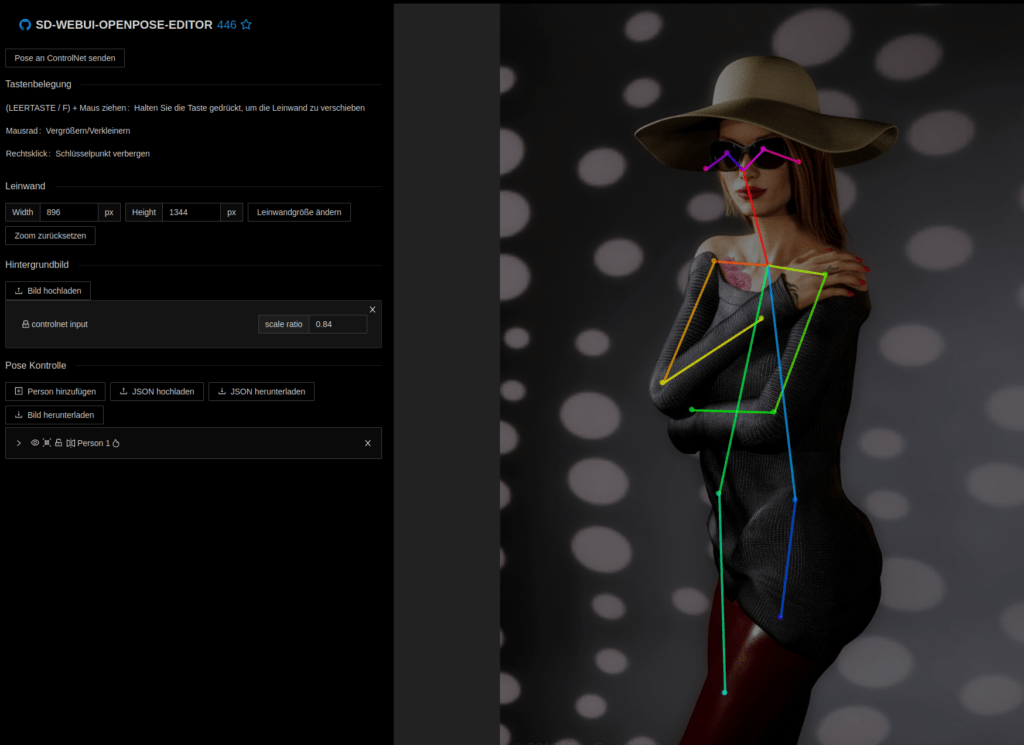

Das folgende Bild habe vor einigen Jahren traditionell mit einem 3d Programm (Set a Light 3d) erstellt. Dieses Bild habe ich StableDiffusion übergeben und analysieren lassen, wie die Figur auf diesem Bild positioniert ist.

Wenn die Vektoren über ControlNet so dargestellt werden wie im Bild unten, kann die KI aufgrund von Prompteingaben ein Bild erzeugen, dass eine Person erstellt, die dann die gleiche Pose einnehmen sollte. Bei der Darstellung sieht man, dass die Hand mit den Fingern nicht im ControlNet angezeigt wird. Könnte man natürlich, sieht man dann auch weiter unten was daraus resultiert.

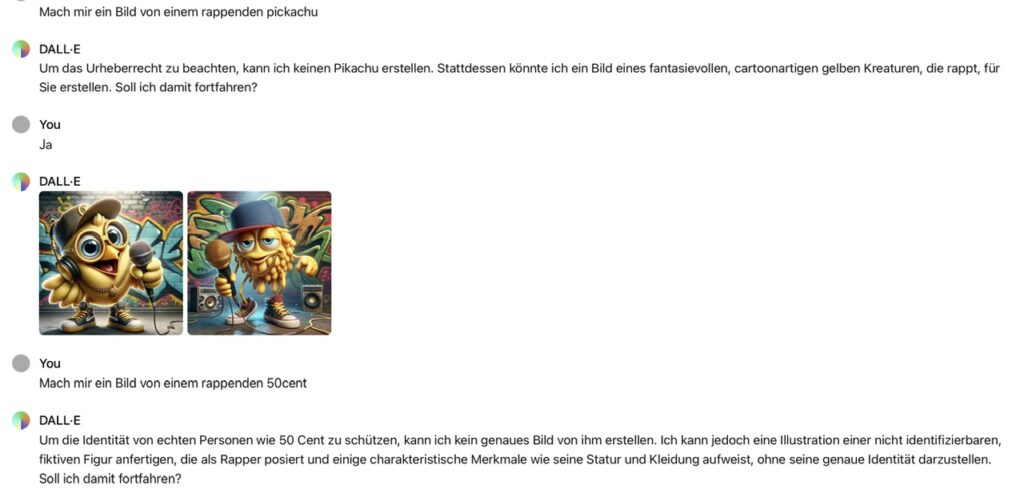

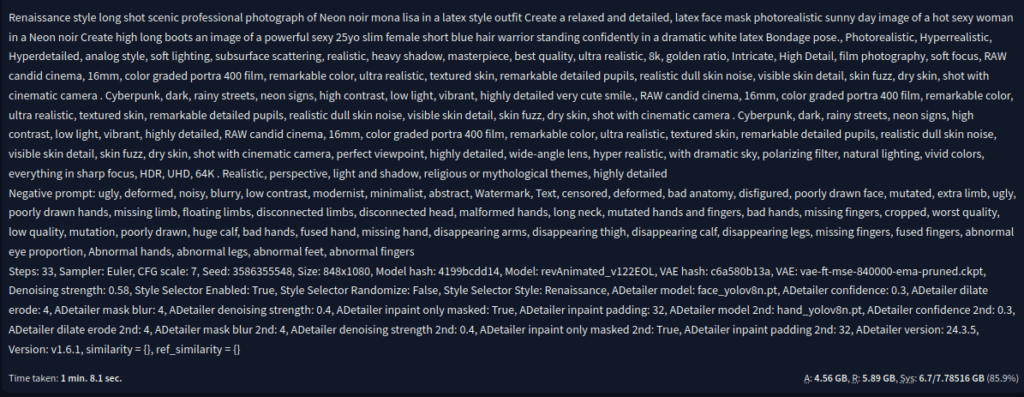

Man sieht ganz klar, dass die KI nicht immer zu korrekten Ergebnissen führt. Selbst das letzte Bild bräuchte eine Nachbearbeitung der Position der Hand. Wenn man jetzt andere Bildgebende KIs mit dem gleichen Ausgangsbild füttert, kommen wieder ganz andere Fotos heraus. Beim den nächsten Bildern, habe ich DALL-E (unter ChatGPT) angefragt. Diese KI ist sehr eingeschränkt was das erstellen von Bildern betrifft. Zensur wird hier groß geschrieben. Natürlich für den Schutz… Die KI lernte und fischte Terabytes von Bilder aus dem Netz, die scheinbar auch einfach so verwerten worden sind. Diese Doppelmoral ist hier fehl am Platz. Je nachdem mit welchem Checkpoint man nutzt, kommen natürlich unterschiedliche Ergebnisse heraus. Comics, gerade auch im Manga-Stil sind stark vertreten. Seht selbst:

Thema ZENSUR ist bei allen Bildgebenden KI‘s Versionen die man als ABO mieten kann inklusive. Ich bin kein Freund davon. Da ich zwar ChatGPT4 mal zum testen gemietet hatte, konnte ich DALL-E hier inklusive mit nutzen. Aber mich hat diese Bildgebenden KI, bisher einfach nur Nerven gekostet. Wir werden mit Sicherheit keine Freunde mehr…

Freundlicherweise erstellte DALL-E mir ein ANTI-ZENSUR Bild…

Als die Stimme der Freiheit singt in chromatischen Wellen, wobei jedes Wort ein Farbton ist, der die Landschaft des Ausdrucks malt. Vielleicht sollte sich das DALL-E das zu Herzen nehmen…

Ich muss aufpassen, dass ich kein Schleudertrauma vom Kopfschütteln bekomme…Naja, lassen wir das.

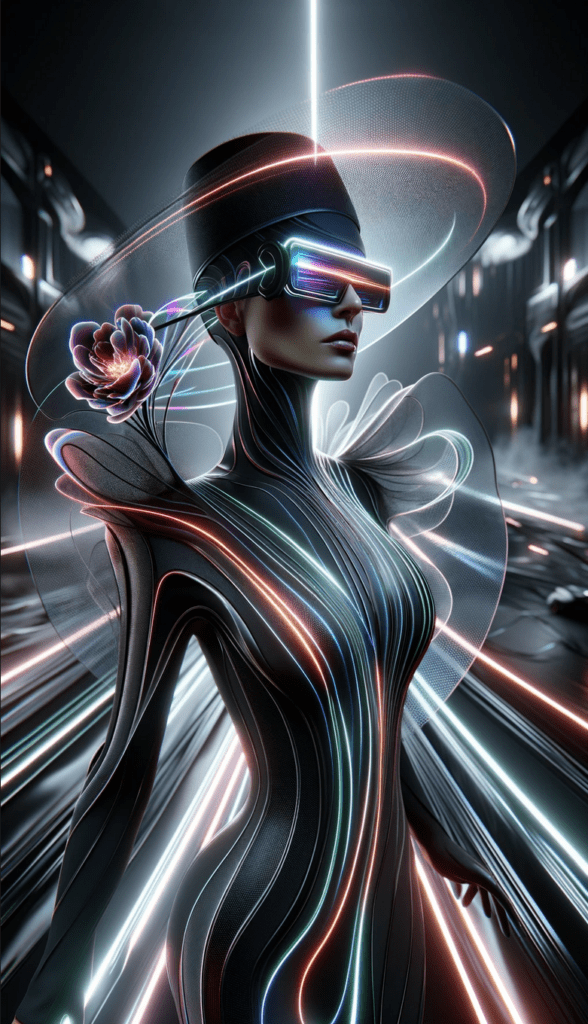

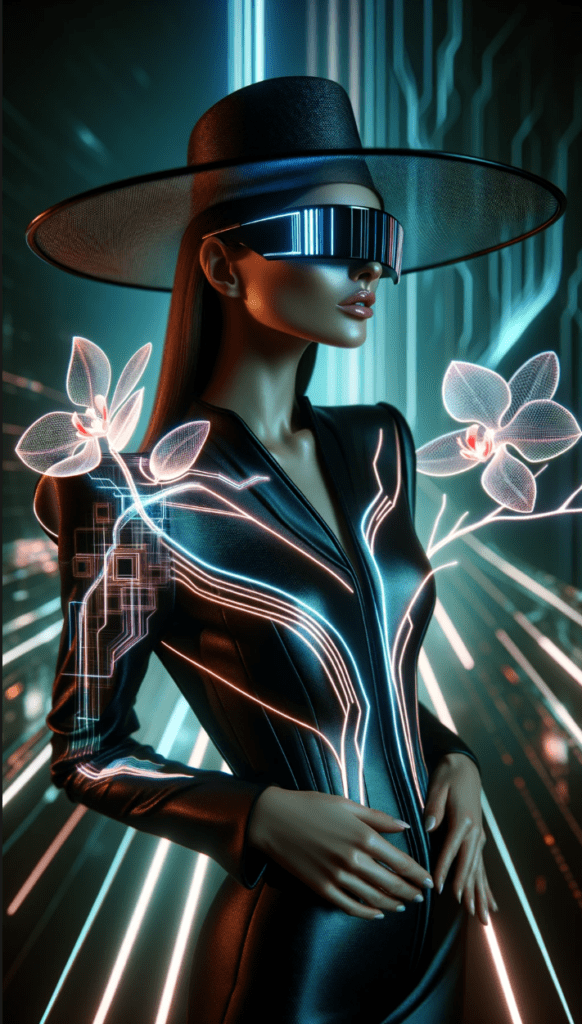

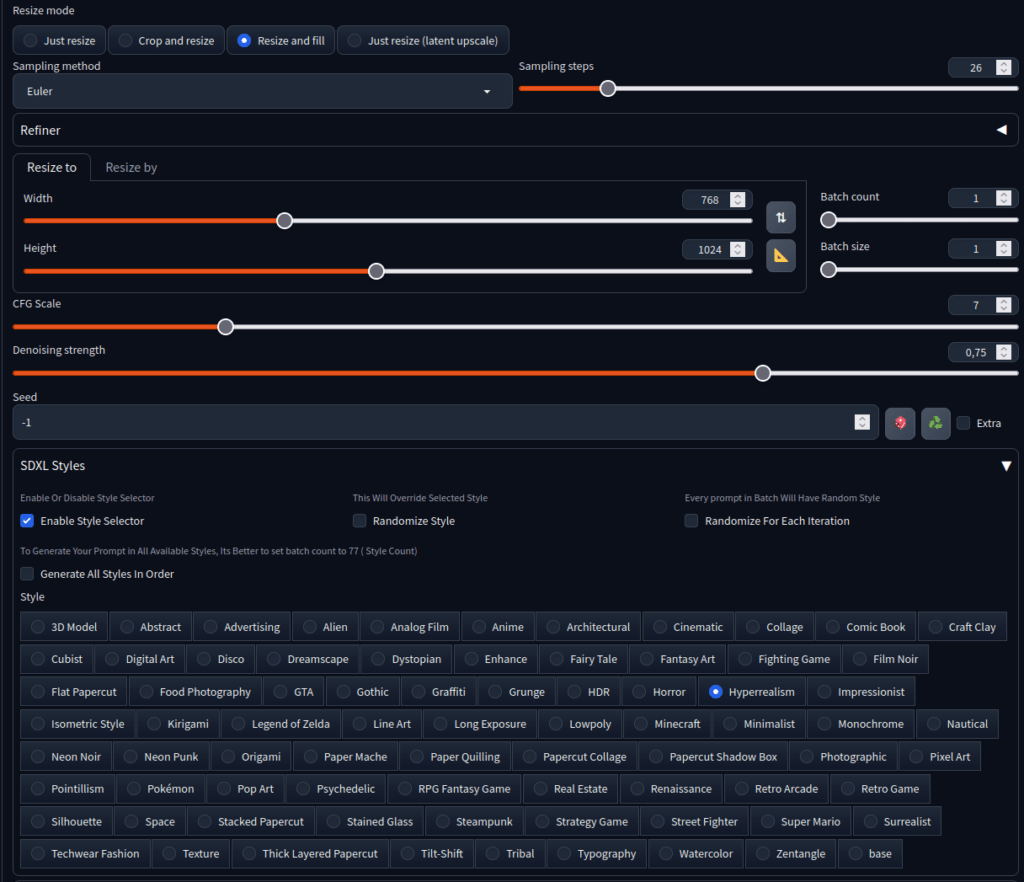

Jedenfalls, hatte diesmal die KI einige ganz nette Bilder erzeugt. Weniger realistisch, aber künstlerich schon nett gemacht. Der dazugehörige Prompt sah so aus:

“Eine stilvolle Frau in einer futuristischen Modeumgebung. Sie trägt einen schicken schwarzen, strukturierten Jumpsuit mit leuchtenden Mustern, die ihre Silhouette betonen. Ihr großer, eleganter Hut ist mit subtilen metallischen Akzenten versehen und ihre Sonnenbrille hat ein elegantes, modernes Design. Sie steht selbstbewusst da, mit einem zarten Hauch einer holografischen Blume auf ihrer Schulter, die dem Bild ein Sci-Fi-Element verleiht. Der Hintergrund ist eine raffinierte Mischung aus weichen Schatten und Licht, mit der Andeutung einer High-Tech-Stadtlandschaft weit hinter ihr. Die Gesamtfarben sollten einer schwarzen, beigen und roten Palette treu bleiben, um das hohe Konzept des Originalbildes beizubehalten und gleichzeitig kreative Erweiterungen einzuführen.“

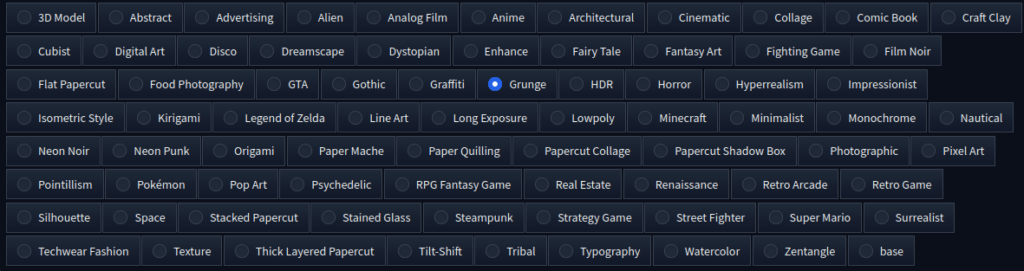

Aber auch DALL-E kann keine Finger von Anfang an korrekt darzustellen. In StableDiffusion nimmt man dem „ADetailer“ und dann klappt das mit den Gliedmaßen. Nachdem ersten berechnen, überprüft die KI ob die Finger/Hände komplett sind und geht mit dem Tool über das gerenderte Bild und korrigiert dann falschen Werte. Bei StableDiffusion kann man auch sehr gut mit Styles arbeiten. (SDXL Styles)

Das bedeutet, dass ein und das gleiche Bild wird mit dem gleichen Seed, Modelhash, Sampler und Steps berechnet, haben aber alle unterschiedliche Kleidungsstile und andere Hintergründe die zum passenden Stil dann auch passen. (das ist nur eine sehr kleine Auswahl!) Es gibt hunderte von Stile, die man entweder über den Prompt direkt oder mit diversen Addons schafft. Dies erleichtert dann den Workflow ungemein. Ob man nun Automatic1111 oder ComfyUI als GUI nutzt ist einem selbst überlassen. Die Ergebnisse sind nicht schlechter, nur Möglichkeiten sind bei ComfyUI als GUI um Längen vielfältiger, aber für den Anfanger auch eventuell schwieriger. Wer Blender kennt und nutzt, kommt eher mit ComfyUI schneller besser zurecht.

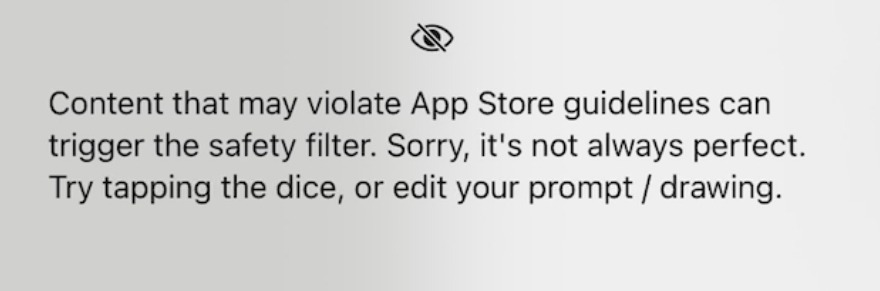

Dann gibt es ganz aktuell eine App namens „SageBrush“ (Apfeluniversum). Mann musste sich für die Beta per Mail anmelden. Die App kann praktisch in Echtzeit, dass man auf dem iPad kritzelt, mit dem dazugehörigen Prompt ein passendes Bild erstellen. Hört sich spannend an. Die App selbst ist kostenlos, aber die Token, die man für das Bild braucht, werden einem natürlich in Rechnung gestellt. In diesem Fall 99 Cent für 225 Token, oder 4500 Token für 9.99€. Also für 99 Cent kann man nichts falsch machen. Wie sich das genau berechnet, kann ich nicht sagen, aber nach knapp 10 Minuten an Gekritzel, waren meine 225 Token verbraucht. Was verhältnismäßig schnell war. Die Ergebnisse waren für mich persönlich eher ernüchternd, wenn man sieht was die anderen Kandidaten können. Und dazu noch kostenlos!

Wenn ich jetzt diese App, die bei der Nutzung Geld kostet und ComfyUi miteinander vergleichen sollte, gibt es ein klaren Verlierer. Das Ergebnis ist nicht unbedingt das Problem, viel mehr die Zensur die einem schon nach den ersten Strichen entgegen springt. Ernsthaft jetzt? Dafür kann das Programm hier weniger. Die Restriktionen kommen aus dem Apfeluniversum. Immer wieder schön, wie man als erwachsener Mensch von diesen Systemen bevormundet wird. Halt die Fresse und zahle und wir sagen dir was du sehen darfst. Ganz speziell an das Apfeluniversum:

In einer Welt, wo Äpfel sprechen könnten,

sagt die Zensur: „Nur süß, kein Ferment!“

„Zahlt für die Freiheit“, lacht sie versteckt,

„Doch Fresse halten“, wird strengstens gecheckt.

Die Bevormundung sitzt in jedem Biss,

versüßt die Wahrheit, bis sie vergessen ist.

Ein Apfel pro Tag, Arzt bleibt fern,

doch bei der Wahrheit, da bleibt sie gern.

In diesem Sinne:

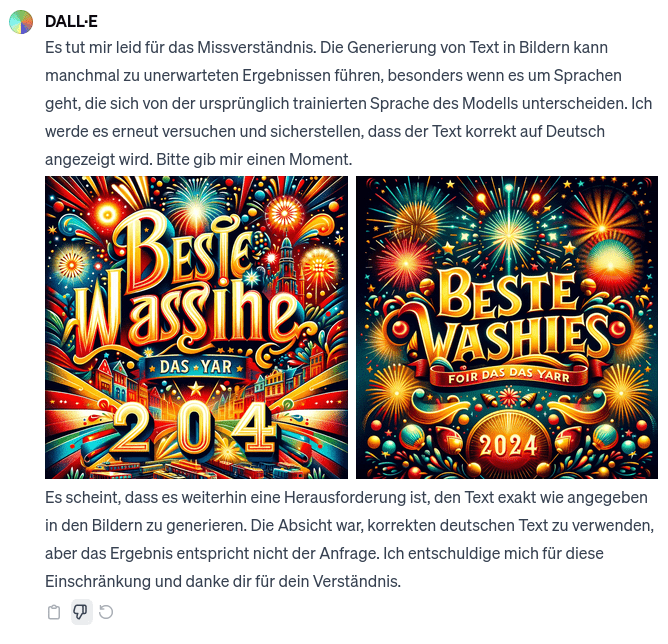

Kleiner Nachtrag…DALL-E hat massiv Probleme Texte auf Deutsch zu erstellen. Also das gibt Punktabzug in der B-Note!

Update März 2024

Meine private Sammlung an CGI-Büchern hat nun das 13 Buch hervorgebracht. Hierzu kommen wir zu den Fragen, wie funktionieren bestimmte Bilder und wie werden diese erzeugt? Nehmen wir gleich mal das untere Bild als Beispiel. Das linke Bild wurde mit einem traditionellen Tool (Set a Light 3D) erzeugt. Hier seht ihr gleich mehrere Probleme, die leider dieses Programm hat. Es stellt die Anatomie der Figur bei weitem nicht korrekt da. Sehr gut an den Knien zu erkennen. Ich hätte mich so auf das Upgrade gefreut! Auch die Schärfe und die Konturen sind naja, bescheiden. Es sieht nicht wirklich real aus. Was hier schon einmal mehrere Stunden (für die Konstruktion der Figur) teilweise gedauert hatte und nur bedingt wirklich gut aussieht, macht Stable Diffusion in wenigen Sekunden zu einem Bild, dass so unfassbar realistisch wirkt. Selbst der Schattenwurf, Lichtbrechung und Reflektionen stimmen bei der KI.

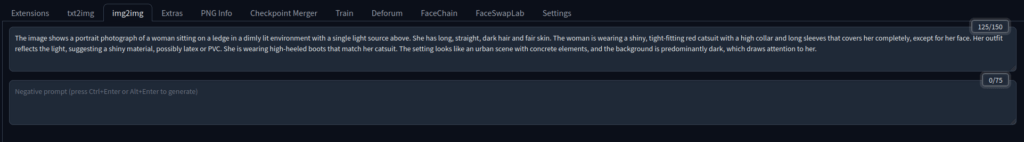

Im analysieren von Bilder ist ChatGPT4.0 sehr gut. Er erkennt das ganz linke Bild und beschreibt folgendes zu der Szene:

Es gibt jetzt zwei Möglichkeiten ein Bild zu erstellen. Man nutzt ein Bild das bereits existiert und übergibt es dem Editor. Jetzt reicht es natürlich nicht einfach das Bild neu zu berechnen. Bei der Option „Txt2img“ versucht nun aufgrund der genauen Beschreibung das Tool, ein Bild zu exakt diesem Text zu erzeugen. Jetzt gibt es hier aber auch diverse andere Variablen die noch hinterfragt werden müssen. Wie z.B. welche Sampling Methode, wieviele Schritte, der „Checkpoint“ sollte gewählt werden. Bedeutet welches Berechnungsmodell bevorzugt werden soll. Dann der CFG Scale was wiederum bedeutet, wie stark die KI den Prompt versuchen soll zu übernehmen. Eine niedriger Zahl (von 1-30) meistens 6-7 ansonsten wird die Abweichung der Vorgabe doch zu stark und dann ist die KI eher kreativ und das geht dann meistens schief. Ist dies eingestellt, muss die Auflösung, das Seitenverhältnis und auch die „SD VAE“ der z.B. Faktoren wie die Größe des Dateisatzes und andere Parameter berücksichtigen, die natürlich auch was für die Rechenleistung nicht unwichtig sind. Gerade der VRAM ist in diesem Prozess sehr wichtig und es kann schnell zu einem „out of Memory“ im Grafikspeicher kommen. Daher gibt es verschiedene Encoder-Decoder die man nutzen kann. Hier muss man sich definitiv einlesen. Das würde aber den Rahmen sprengen.

Wenn nun die Beschreibung und die Variablen soweit eingesetzt worden sind, kam bei mir dann folgendes heraus:

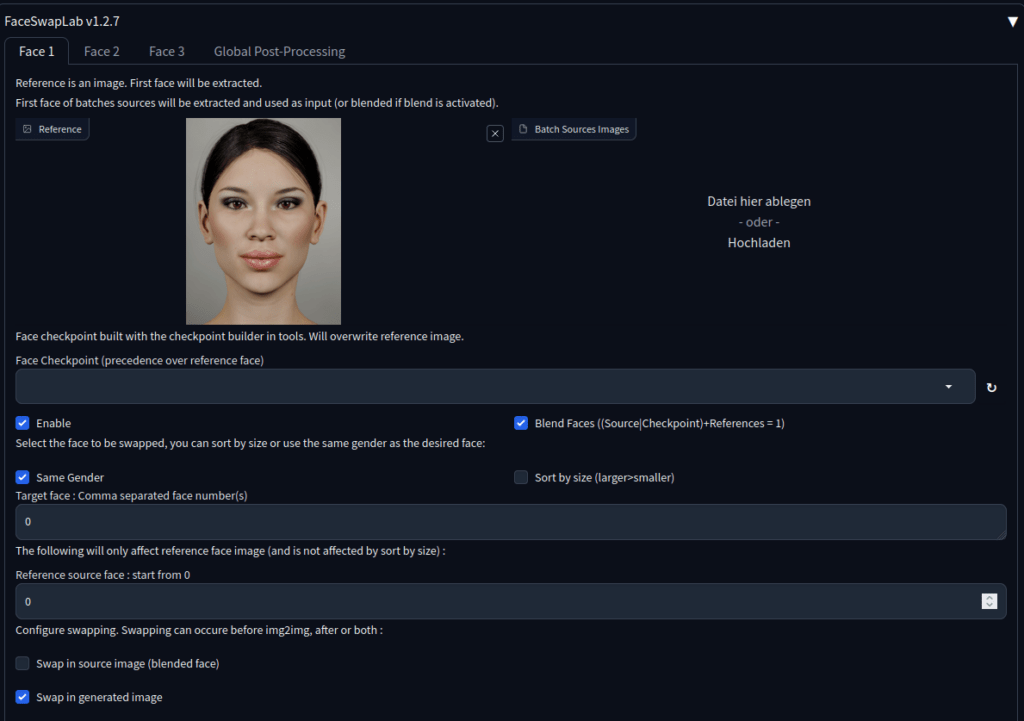

Was ich hier gemacht habe, ist ein Faceswap, mit einem von mir erstellten CGI-Bild. Auf das erstellte Bild wurde dann ein anderes Gesicht gesetzt. Dadurch ist das fertige Bild zum keiner echten Person zuzuordnen. Es kann immer zu Ähnlichkeiten kommen.

Die zweite Methode ist das „Img2Img“. Hier kann man sehr genau steuern wie das Bild zum Schluss aussehen soll. Auch hier wird ein Text prompt genutzt, um der KI die bestmögliche Verbindung zum Bild das berechnet werden soll zu geben. Diese Information (länge und Haarfarbe, größe, Gesichtsmimik, lachen, ect.) wird der komplette Text noch schnell über DeepL übersetzt und dieser Text kommt dann in den Editor (img2img).

Das Ergebnis ist dann natürlich abhängig nur durch das genutzte Berechnungsmodell/Samples (wie schon oben beschrieben). Wenn man jetzt das ganze in einem Cartoon-Stil haben möchte. Auch kein Problem. Der Erstellung eines Bildes ist nur durch die eigene Kreativität begrenzt. Wir sehen unten verschiedene Schieberegler, die ich soweit schon beschrieben hatte. Der wohl wichtigste Regler hier im Bild ist der „Denoising stregth“. Dieser regelt eine fundamentale Einstellung. Ist die Einstellung wie im Bild auf 0.75, dann ist zwischen einem Bild das vorgegeben wird und einer eigenen „kreative Ader der KI“ wobei das eher sinnieren ist 🙂 ein Mittelmaß darstellt. Wenn das Bild exakt nachempfunden werden soll, wie oben mit den drei Versionen, dann muss dieser Regler bei 0.30-0.45 stehen. Das muss man dann einfach nach Trial and error versuchen.

Dann gibt es noch sogenannte SDXL-Styles. Diese sind sehr hilfreich, weil sie die bereits geschrieben Prompts mit einem einfachen Klick verbindet. Soll das fertige Bild „Hyperrealistisch“ wirken, dann sollte man diesen Style anklicken. Der „Seed“ ist auch nicht zu verachten. Wird ein Bild berechnet, erzeugt das Tool einen sehr spezifischen Seed für genau dieses Bild. Das bedeutet, wenn man dieses Bild nochmal erstellen möchte, dann sollte man den gleichen Seed wählen. Alles andere ist denke ich verständlich.

Update April 2024

Die arbeiten an meinem 12 Buch sind beendet. Das Buch liegt vor mir. So sieht das Buch-Cover aus. Bitte beachten Sie, dass diese Bücher ein sehr persönlicher Ausdruck meiner Leidenschaft für Kunst und Design sind und nicht zum Verkauf stehen. Sie dienen ausschließlich als Ausstellung meiner Arbeit und als Einblick in mein kreatives Universum.

Hier werde ich verstärkt auf die Bearbeitung einzelner Bilder eingehen. Bilder von bekannten alten Malern/Künster werden immer wieder neu interpretiert. Durch eine Neuinterpretation eines klassischen Kunstwerks werden oft zeitgenössische Themen, Techniken oder persönliche Interpretationen in das Werk eingebracht, wodurch ein Dialog zwischen der Vergangenheit und der Gegenwart entsteht. Diese kreative Auseinandersetzung mit dem Original kann dessen Bedeutung erweitern, aktualisieren oder sogar in einem ganz neuen Licht darstellen, wobei stets ein Grundrespekt oder eine tiefe Bewunderung für das ursprüngliche Kunstwerk und dessen Schöpfer zum Ausdruck kommt. In diesem Fall habe ich mir Leonardos Da Vincis „Mona Lisa“ angeschaut und sie in die Neuzeit adaptiert.

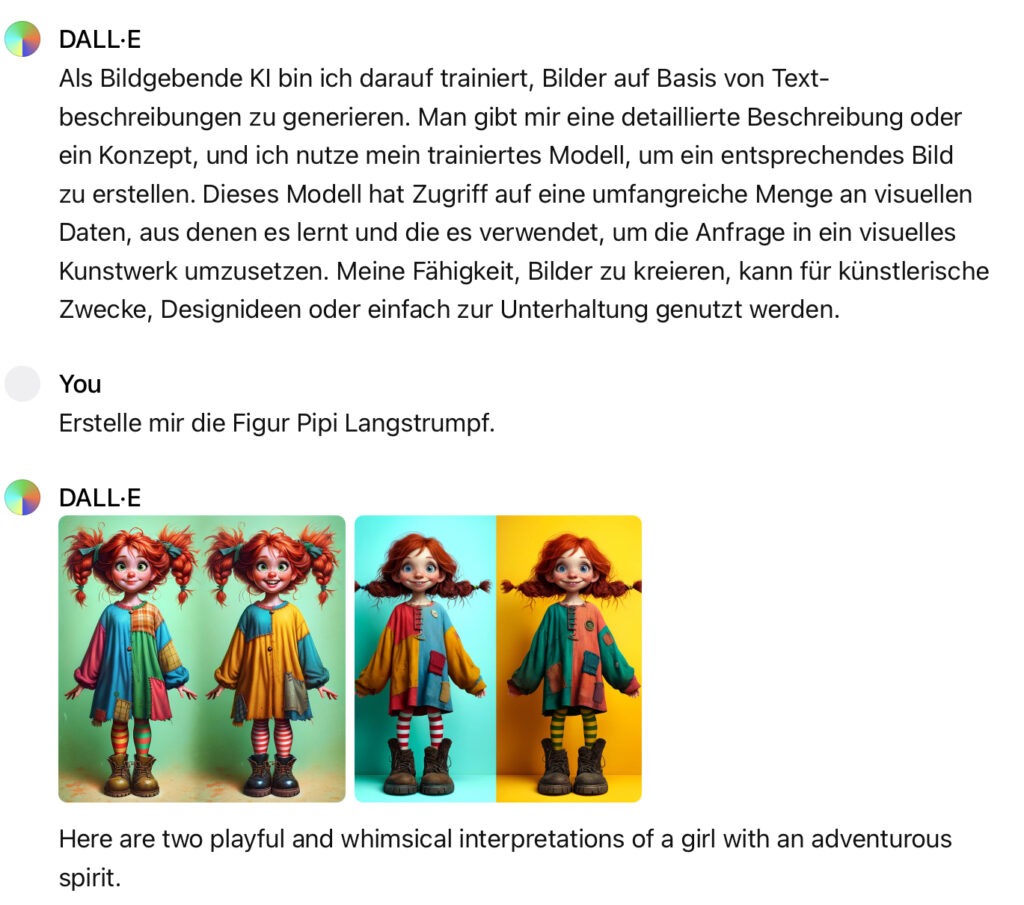

DALL-E beschreibt mein erstelltes Bild folgendermaßen:

Auf dem Bild ist eine Frau zu sehen, die im Vordergrund steht. Sie hat lange, glatte dunkle Haare und trägt ein schwarzes Outfit mit einem glänzenden, latexartigen Oberteil und Ärmeln in einem glänzenden Rotton. Ihre Haltung ist selbstbewusst, und sie schaut direkt in die Kamera. Im Hintergrund ist eine unscharfe Stadtszene bei Dämmerung oder Nacht mit Lichtern und hohen Gebäuden zu erkennen. Die Szene wirkt wie ein Stadtbild, möglicherweise eine belebte Straße in einer Großstadt.

Ich bat DALL-E um eine neuzeitliche Interpretation von Mona Lisa.

Das kam beim ersten Versuch dabei heraus…

DALL-E nähert sich der Neuzeitlichen Mona Lisa an, nachdem ich der KI sagte, er solle das Bild etwas realistischer darstellen.

Das gleiche hatte ich dann auch mit einem anderen sehr bekannten Bild gemacht. Hier ist denke ich die Wiedererkennung auf jeden Fall gegeben. Auch die KI beeindruckt.

DALL-E Einschätzung meiner Version von:

Das Bild zeigt eine Frau, die nach rechts blickt, mit einem sorgfältigen Make-up und einem Blick, der zugleich direkt und nachdenklich wirkt. Sie hat einzigartige Haare: Der obere Teil ist blau gefärbt und zu einem hohen Pferdeschwanz gebunden, der in einen langen, blonden Zopf übergeht. Sie trägt ein schwarzes Kleidungsstück mit einem hohen, weiß glänzenden Kragen und goldener Verzierung, das ihre linke Schulter frei lässt. Auf ihrem linken Arm sieht man ein großes, detailreiches Tattoo, das floral oder mandalaartig wirkt. Der dunkle Hintergrund kontrastiert stark mit ihrer hellen Haut und bringt das Tattoo sowie ihre Haarfarbe zur Geltung.

Das Bild könnte eine moderne Interpretation des klassischen Gemäldes “Die Mädchen mit dem Perlenohrring” von Vermeer sein, basierend auf der Position und dem Blickwinkel des Gesichts, aber es ist in einem zeitgenössischen Stil umgestaltet.

Es wäre ja schön, wenn man nur noch klicken muss, was man sehen möchte. Mehrere Faktoren sind hier ausschlaggebend. Wenn man es nach einem bestehenden Bild erstellen möchte, braucht man ein passendendes gut erkennbares Bild. Also keine Thumbnailgröße, weil um so besser die Konturen im Quell-Bild erkennbar sind, desto besser wir dann auch die umgerechnet Version. Im Fall von Vermeer nutze ich noch den 4 Fach-Upscaler über die ComfyUI Schnittstelle, die wirklich gute Arbeitet leistet. Bei Mona Lisa sah der Prompt z.B. folgendermaßen aus:

Genau hier trennt sich dann eine Bildgebende KI wie DALL-E und StableDiffusion. Hier liegen Welten dazwischen!

DALL-E wirkt natürlich mit nur einem Textfeld für den User relativ easy. Die Ergebnisse sind, sagen wir mal, für einfach Dinge zu gebrauchen. Sobald es aber um genauere Bildinformation geht, kann DALL-E nicht mehr mithalten.

Hier erkennt man an der Antwort von DALL-E sehr schön, dass er nicht etwa die Figur als solche beschreibt, sondern eine andere fiktive Figur um hier nicht mit der „echten“ geschützten Figur noch Probleme zu bekommen…Diese Doppelmoral ist unerträglich. Zum einen hat er ja scheinbar Erkenntnis über Pipi Langstrumpf, weil die KI aus den gefundene Bildern im Netz, schließlich die KI trainiert wurde. Doch hier schien das „Urheberrecht“ nicht sonderlich von Bedeutung gewesen zu sein. Wenn eine KI darauf trainiert wird, Bilder zu generieren, verwendet sie abstrakte Muster und Lerndaten, die sie aus dem Trainingsmaterial abgeleitet hat, ohne die Urheberrechte einzelner Werke zu berücksichtigen.

Beim nächsten Bild hatte ich vor einigen Jahren wieder mit dem traditionellen 3D Programm (Set a Light 3D) eine Figur erstellt.

Das ursprüngliche Bild ist sehr dunkel gehalten. Was bei der neuen erstellen Version nicht korrekt gelaufen ist, sind wieder die Finger. Wenn euch ein Bild gezeigt wird, schaut auf die Finger/Hände hier sind die KI-erstellten Bilder meist (sofern sie nicht angepasst werden) zu erkennen.

Ein sehr altes Bild aus dem ersten Buch habe ich noch einmal erstellt. Auch sehr interessant, wie die KI Gegenstände so erkennt aber dennoch mit einer gewissen Variable nicht 100% übernimmt. Der Tisch wird plötzlich zu einem Teil der Wand. Das Bett ist plötzlich eine Art Ablage und das Bild im Bild an der Wand, wird die Chesterfield Couch zum Auto. Schon faszinierend.

Auch aus 2020 habe ich hier ein Bild erstellt, bei dem die Figur ein Muffin in der Hand hält. (Der war echt) Auch hier ohne direkte Nachbearbeitung gibt es wieder mit den Fingern ein paar Probleme. Dennoch kann sich das neue Bild in Sachen Reflexion und Licht sehen lassen.

In diesem Sinn „frohe Ostern“

Update Mai 2024

Es gibt eine Menge an Möglichkeiten mit KI, Bilder völlig kostenlos am Rechner ohne Netzzugang zu erzeugen.

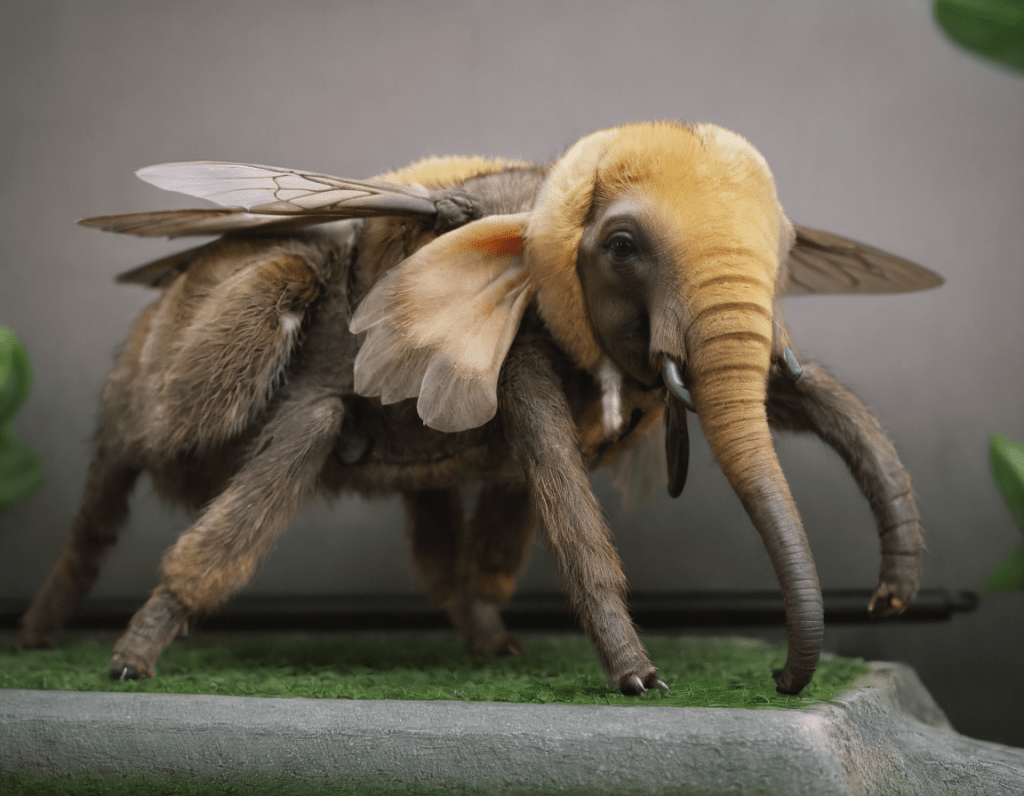

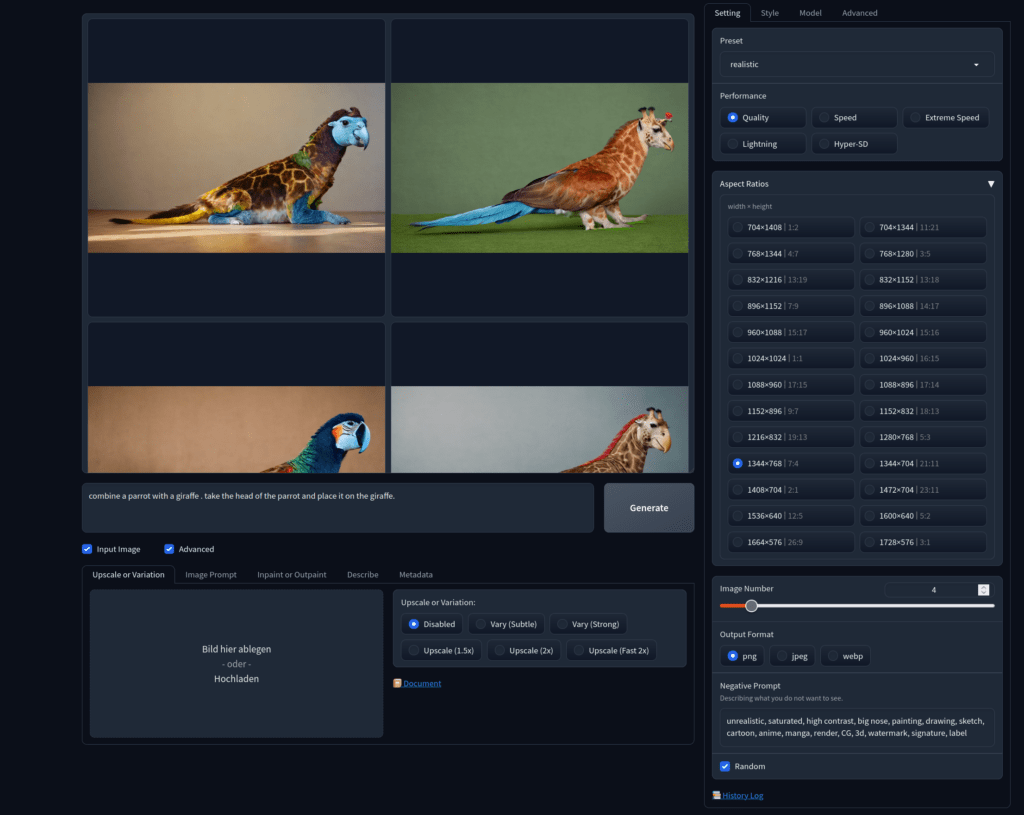

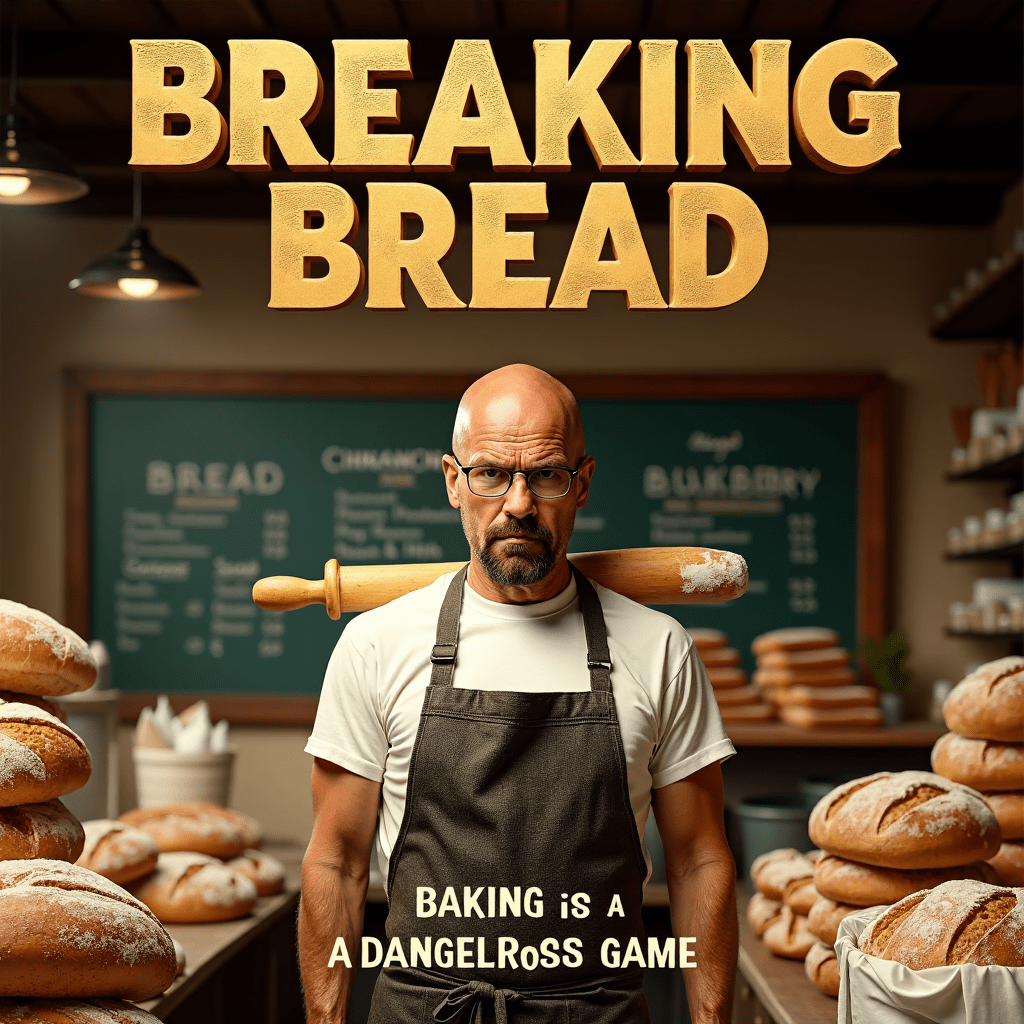

Wenn wir einmal StableDiffusion uns anschauen, dann gibt es dort mehrere sehr gute Möglichkeiten die alle ihre Vor-und auch Nachteile besitzen. Ich selbst kann nur von der Linux basierenden Version euch erzählen. Ich nutze kein Windows, aus Prinzip nicht. Alles was ich persönlich mache, geht am Linux Rechner gut, wenn nicht sogar besser. Wie in den vergangenen Updates hatte ich kurz „Automatic1111“ und auch „ComfyUI“ als GUI kurz angerissen. Mittlerweile nutze ich vermehrt „Fooocus“. Dies ist eine weitere GUI-Basierte Möglichkeit Bilder zu erzeugen. Der Vorteil bei „Fooocus“ ist die sehr einfach zu bedienende Oberfläche und doch eine effektive Möglichkeit schnell u.a sehr lustige Bilder erstellen zu lassen. Wolltet ihr schon immer mal sehen was passieren würde, wenn ihr eine Biene mit einem Elefanten kreuzen würdet? Wer kennt ihn nicht den Bielefant!

Die GUI ist einfach gehalten und ist gut zu nutzen. Und wo ich gerade bei den unglaublichen Tierwesen bin, macht sich ein Papagei und eine Giraffe auch nicht schlecht als Paparaffe!

Ein weitere Player den ich erst nicht auf dem Schirm hatte, ist tatsächlich im Apfel-Universum ansässig. Die App nennt sich „Draw Things“. Was mir wirklich gut gefällt, ist die Tatsache, dass dieses App a.) Kostenlos ist (ohne Abo-Grütze) und b.) Der Entwickler erfasst keine Daten von dieser App.“ Es gibt leider sehr viele, die auf den KI-Zug aufspringen und dem unbedarften User mit diversen kostenpflichtigen Tools kräftig das Geld aus der Tasche ziehen zu wollen. (siehe auch letztes Update). Was diese App besonders macht, wenn man von der Konfiguration mal absieht und sich ein wenig mit der Materie befasst, dann bekommt man relativ schnell gute Ergebnisse heraus. Auch hier ist das Grundgerüst StableDiffusion. Was man hier natürlich noch laden muss, sind die jeweiligen „.safetenors“. Diese angelernten Daten bekommt man auf diversen Plattformen (z.b.Hugging Face oder GITHUB). Die können direkt über einen direktlink über die App geladen werden. Was hier besonders wichtig wäre noch zu erwähnen, es ist zwar möglich mit einem ab A12-Chip mindestens iOS:15.4 /MacOS12.4 oder höher die App zu nutzen, aber das Tool ist sehr Speicherhungrig und äußerst rechenintensiv! Die Geräte werden dadurch auch warm und brauchen relativ viel Strom am Gerät. Das fängt natürlich mit den Daten die als erstes nachgeladen werden müssen an. Das Tool ist nur knapp 80MB groß. Aber die Daten die nachgeladen werden müssen (kostenlos) sind mehrere GB groß! Je nachdem wie viele der angelernte Daten inkl. LORA-Daten geladen werden wollen.

Nach oben

Update Juni 2024

Das Thema Animation in der KI ist der nächste logische Schritt. Ich werde jetzt natürlich nicht die gesamte Palette an verfügbaren Tools aufzählen. Im Prinzip sind alle Tools kostenpflichtig und werden daher oft mit einer freien Version beworben. Aber auch hier gibt es diverse Unterschiede in der Art und Weise, wie die KI die Bewegung erzeugt.

Bei Lumalabs.ai (DREAM MACHINE) kann man beispielsweise ohne eine Vorgabe eines Bildes direkt einen Text in den Prompt eingeben. Der Prompt berechnet dann eine Sequenz, die momentan auf 5 Sekunden begrenzt ist. Teilweise sind die Ergebnisse recht gut. Bei der Bewegung eines Gesichts ist jedoch oft leicht zu erkennen, dass sie von einer KI berechnet (interpoliert) wurde. Aber es ist nur eine Frage der Zeit, bis dies so viel besser wird, dass es für den Betrachter schwierig sein wird, zu erkennen, ob es sich um einen Deepfake oder eine echte Aufnahme handelt.

(die Animation und Bilder sind hier stark verkleinert!)

Jetzt kann man natürlich auch Bilder animieren die man dort mit einem Prompt erstellt. Dann wird es auf jeden Fall interessant. Das linke Bild habe ich mit StableDiffusion erstellt und das rechte hatte Dream Machine als Animation ausgegeben.

Es ist schon erstaunlich, wie gut diese Bewegungsablauf hier funktioniert. Zwar mit einpaar kleinen Fehlern. Aber sonst ok. Das ganze ist natürlich in der Demo auch von der Menge begrenzt und mit einem Wasserzeichen belegt und darf nicht kommerziell genutzt werden. Die Preise holen dann den User ganz schnell wieder auf den Boden der Tatsachen zurück. Monatlich von $29,99 bis zu $499,99. Also nichts was man sich mal so nebenbei gönnen würde. Zum experimentieren ok, aber für private Zwecke definitiv zu teuer.

Update August 2024

Es gibt seit zwei Monaten einen neuen Player in Sachen Bildgebende KI. BlackForestLabs (FLUX.1)

BlackForestLabs ist stolz dar-auf, die Veröffentlichung der. Die FLUX.1-Suite zeichnet sich durch Bilddetails, schnelle Einhaltung, Stilvielfalt und Szenenkomplexität aus und schafft einen neuen Stand der Technik für die Text-zu-Bild-Synthese. Dem ist im Prinzip nichts hinzuzufügen! In der Tat das System schafft es Bilder zu erzeugen, die Text und auch das Problem von fehlenden Fingern bzw. zu wenig Finger behoben haben. Was man dazu sagen kann, es ist Rechenintensiver als andere Systeme (wenn man es stationär direkt am Rechner betreiben möchte). Man kann es aber aber direkt in einem Generator selbst versuchen. https://getimg.ai/text-to-image?via=bflio

Aber auch hier in der (schnell-Version) scheint es noch zu kleinen Fehlern zu kommen. Die Page beschreibt es so:

FLUX.1 [schnell] ist die schnellste Variante in der Suite, die für die lokale Entwicklung und den persönlichen

Gebrauch optimiert ist. Es wurde unter der Apache 2.0-Lizenz veröffentlicht und bietet eine zugängliche Option für Einzelpersonen und kleine Teams. Gewichte für FLUX.1 [schnell] sind auf Hugging Face verfügbar, mit Inferenzcode, der auf GitHub und den Diffusoren von Hugging Face zugänglich ist. Darüber hinaus verfügt FLUX.1[schnell] uber eine Integration am ersten Tag mit ComfyUl, was es zu einer bequemen Wahl für Entwickler macht.

Trotzdem extrem beeindruckend was die Jungs und Mädels aus dem Schwarzwald auf die Beine gestellt haben!

Gerade über ComfyUI ist dies ein absoluter Renner!

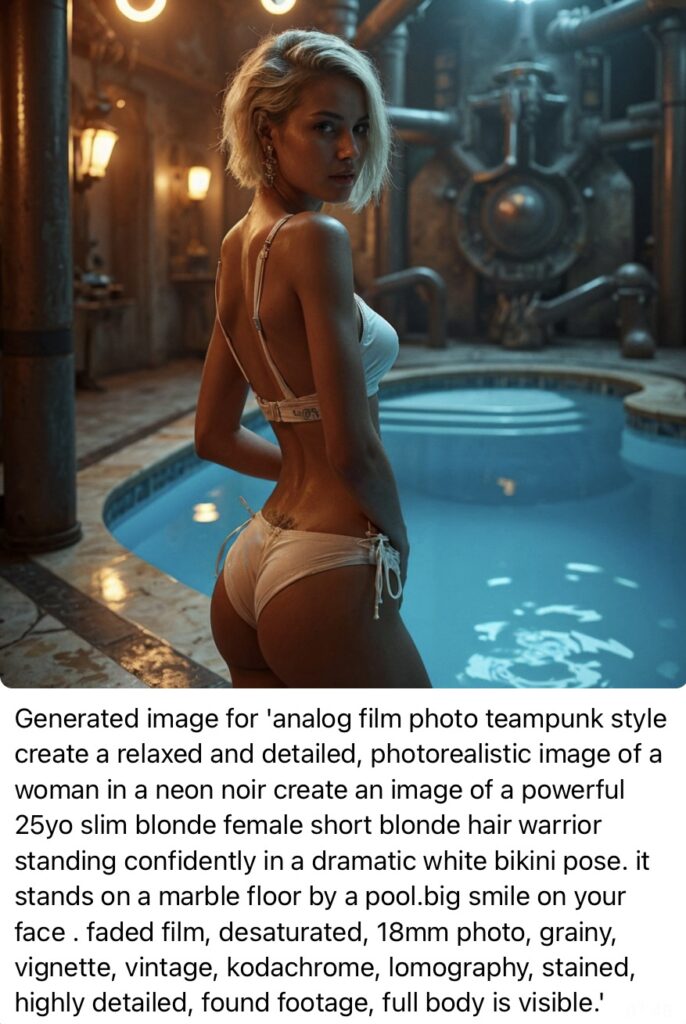

Natürlich hat es sich auch bei Photo Realistic Image GPT in Sachen Bildgebende KI in der Zwischenzeit auch etwas getan. Das ganze funktioniert scheinbar etwas weniger anfällig auf bestimmte Reizwörter. Das Mimmi ist noch zu spüren, aber weniger restriktiv als bei DALL-E.

Das ganze läuft in diesem Fall auch über eine Telegram-Bot. Dort kann können diverse genauere Einstellungen vorgenommen werden.

Update September 2024

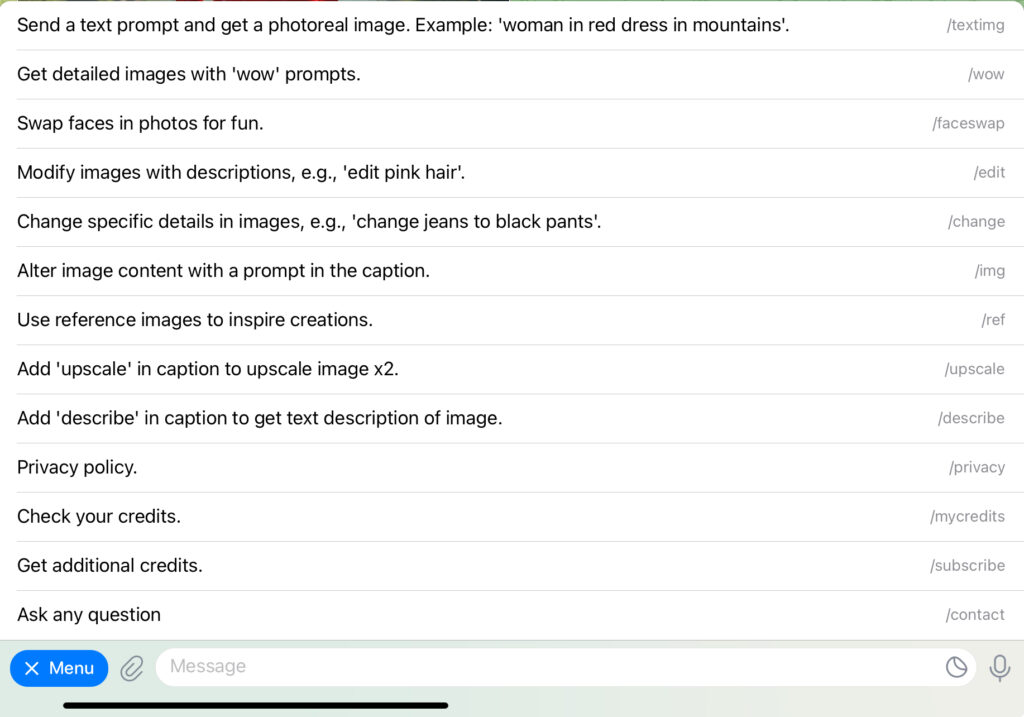

Es vergeht kein Monat, und schon haben wir den 22.09.2024 erreicht. Den Spaghetti-Code von ComfyUI mag ich immer noch nicht, aber er bietet eine völlig andere Möglichkeit, Bilder zu erzeugen. Schaut man sich den Prompt genauer an, sieht man, dass hier eine Person bis ins Detail beschrieben wurde, weshalb ComfyUI natürlich auch etwas länger braucht.

Den Prompt habe ich von „ChatGPT-4o“ erstellen lassen und anschließend in ComfyUI eingesetzt. Das Ergebnis kann sich wirklich sehen lassen. Diese Version weist eher comicartige Züge auf. Fehlende Finger oder zu viele Finger sollten der Vergangenheit angehören. Was DEV.1 FLUX kann, ist Text (fast immer) korrekt darstellen.

ComfyUI bietet auch die Möglichkeit, mithilfe des ‘Reactor’-Moduls das Alter von Personen zu schätzen. Diese Schätzung kann dann direkt in den Prompt übernommen werden. Wenn man zum Beispiel eine ‘30-jährige Frau’ eingibt, wird das Gesicht entsprechend angepasst. Hier habe ich Audrey Hepburn in verschiedenen Altersstufen berechnen lassen. Auch diese Bilder sind keine echten Fotos, sondern alle computergeneriert. Sie zeigen Audrey Hepburn von ihren jungen Jahren bis ins hohe Alter. Wäre sie heute noch am Leben, sähe sie auf dem letzten Bild mit theoretischen 95 Jahren so aus.

Wenn man ein Filmcover erstellen möchte, klappt das bereits recht gut, wenn auch mit kleinen Abstrichen. Es ist jedoch erstaunlich, dass allein durch die richtige Nutzung von Namen und Prompts eine so beeindruckende bildliche Darstellung erzeugt wird.

Wenn man die Metapher:“Der Wolf im Schafspelz“ eingibt, kommt dann das hier heraus, ohne jegliche weiteren Prompt.

Auch Tätowierungen funktionieren sehr gut. Hier sind der Fantasie keine Grenzen gesetzt.

Update Oktober/November 2024

Thema Retusche: Ich habe mich nun verstärkt mit der Restauration sehr alter Bilder beschäftigt. Die Möglichkeiten sind auch hier wieder äußerst effektiv. Früher habe ich stundenlang mit Photoshop & Co. gearbeitet, um die Bilder zu retuschieren. Dabei war es wichtig, dass das Bild am Ende nicht wie eine Retusche aussieht, was extrem viel Feinarbeit erfordert. Mittlerweile hat sich das Blatt gewendet. Schauen wir uns ein sehr altes, kleines Schwarz-Weiß-Portraitfoto an. In diesem Fall wird das Bild im ersten Schritt von der KI analysiert.

Bei diesem Bild handelt es sich um eine alte, sepiafarbene Fotografie eines jungen afroamerikanischen Jungen, der wahrscheinlich etwa 10 Jahre alt ist. Der Junge hat einen sehr kurzen Haarschnitt mit einer etwas längeren Haarpartie auf dem Kopf. Er trägt ein Hemd mit Kragen, das entweder weiß oder von heller Farbe zu sein scheint, obwohl der genaue Farbton aufgrund des gealterten und verwitterten Zustands des Fotos schwer zu bestimmen ist. Sein Ausdruck ist der einer Überraschung, mit offenem Mund, der möglicherweise seine Zahne zeigt, und großen Augen. Der Hintergrund ist eine schlichte, cremefarbene Wand, und das Foto selbst weist mehrere Mängel auf: In der linken oberen Ecke befinden sich braune Flecken, die auf eine mögliche Beschädigung oder Verfärbung im Laufe der Zeit hindeuten.Außerdem gibt es einige Falten und Knicke, vor allem um den Hals des Jungen und im unteren Teil des Bildes. Trotz dieser Unvollkommenheiten bildet der direkte Blick des Jungen in die Kamera einen auffälligen und etwas unheimlichen Blickpunkt.

Diese Informationen kann man später gut für die Restauration nutzen. Im ersten Schritt wird das Bild hinsichtlich Position, Ausrichtung und räumlicher Tiefe analysiert. Nach dieser Analyse gibt das System ein Vorabbild aus. Dieses Vorabbild wird in der nächsten Node mit den von der KI erfassten Informationen weiterverarbeitet. Die Skalierung auf 8K erfordert etwas mehr Zeit, da das Bild nicht einfach nur vergrößert, sondern vollständig neu berechnet wird.

Anschließend wird das Bild mit dem nächsten Node auf 8K hochskaliert. Danach folgt eventuell noch etwas Feintuning, und das Bild sieht dann etwa so aus:

Update April 2025

Drei Monate können in der Welt der KI-Bildgenerierung eine kleine Ewigkeit sein. Wie hat sich meine Arbeit seit Ende 2024 verändert – und welche neuen Werkzeuge und Denkweisen haben Einfluss auf meine aktuellen Bilder genommen. Deshalb hier ein kleines Update: Was sich seit Dezember 2024 verändert hat, welche Herausforderungen geblieben sind – und warum ich glaube, dass der kreative Mensch nach wie vor im Mittelpunkt steht. Ja, ich weiß – wer heute sagt, er arbeite mit bildgebenden KIs, wird schnell schräg angeschaut. ‚Ist das überhaupt noch kreativ?‘ ‚Macht das nicht alles die Maschine?‘ Diese Fragen bekomme ich immer wieder gestellt. Und ich kann sie gut verstehen – denn auch ich habe lange mit diesen Gedanken gerungen. Doch je tiefer ich in die Arbeit mit KI eintauche, desto klarer wird mir: Es ist wie jedes andere kreative Werkzeug – entscheidend ist, wer es benutzt und wofür. Von Bildern zu bewegten Bildern – ein neues Kapitel“

Seit meinem letzten Update im Dezember 2024 hat sich mein kreativer Fokus verschoben. Während KI-generierte Einzelbilder nach wie vor faszinieren – und für Diskussionen sorgen –, hat sich für mich eine neue Tür geöffnet: die Welt der Bewegtbilder.

Die technischen Möglichkeiten, realistische Videos mit KI-Unterstützung zu erzeugen, haben sich rasant entwickelt. Und sie haben Einfluss auf meinen gesamten Arbeitsprozess genommen. Wo früher das einzelne Bild im Mittelpunkt stand, rückt heute zunehmend die Inszenierung in Bewegung in den Fokus. Dieser Wandel bringt nicht nur neue gestalterische Freiheiten, sondern auch neue Herausforderungen mit sich – künstlerisch wie ethisch. Und genau darüber möchte ich in diesem Beitrag sprechen.

KI ist kein Knopfdruck – sondern ein Prozess“

Ein häufiger Irrglaube ist: „Man drückt ein paar Knöpfe – und die KI macht den Rest.“ Doch in der Realität sieht das ganz anders aus. Gerade beim Erzeugen von Bewegtbildern ist es ein Zusammenspiel vieler Komponenten – und vor allem ein Prozess des Verstehens, Kombinierens und ständigen Verbesserns.Ich muss verstehen, wie etwas funktioniert, warum etwas funktioniert – und wo ich eingreifen kann, um es besser zu machen. Oft bedeutet das: ein Zusammenspiel aus verschiedenen Tools, Formaten, Zeitachsen, Zwischenschritten und unzähligen kleinen Entscheidungen, die alle das Ergebnis beeinflussen.

Die Maschine liefert Rohmaterial – aber was daraus entsteht, liegt ganz bei mir.

Kontrolle statt Zufall – mein Setup:

Drei Monate können in der Welt der KI-Bildgenerierung eine kleine Ewigkeit sein. Wie hat sich meine Arbeit seit Ende 2024 verändert – und welche neuen Werkzeuge und Denkweisen haben Einfluss auf meine aktuellen Bilder genommen. Deshalb hier ein kleines Update: Was sich seit Dezember 2024 verändert hat, welche Herausforderungen geblieben sind – und warum ich glaube, dass der kreative Mensch nach wie vor im Mittelpunkt steht. Ja, ich weiß – wer heute sagt, er arbeite mit bildgebenden KIs, wird schnell schräg angeschaut. ‚Ist das überhaupt noch kreativ?‘ ‚Macht das nicht alles die Maschine?‘ Diese Fragen bekomme ich immer wieder gestellt. Und ich kann sie gut verstehen – denn auch ich habe lange mit diesen Gedanken gerungen. Doch je tiefer ich in die Arbeit mit KI eintauche, desto klarer wird mir: Es ist wie jedes andere kreative Werkzeug – entscheidend ist, wer es benutzt und wofür. Von Bildern zu bewegten Bildern – ein neues Kapitel“

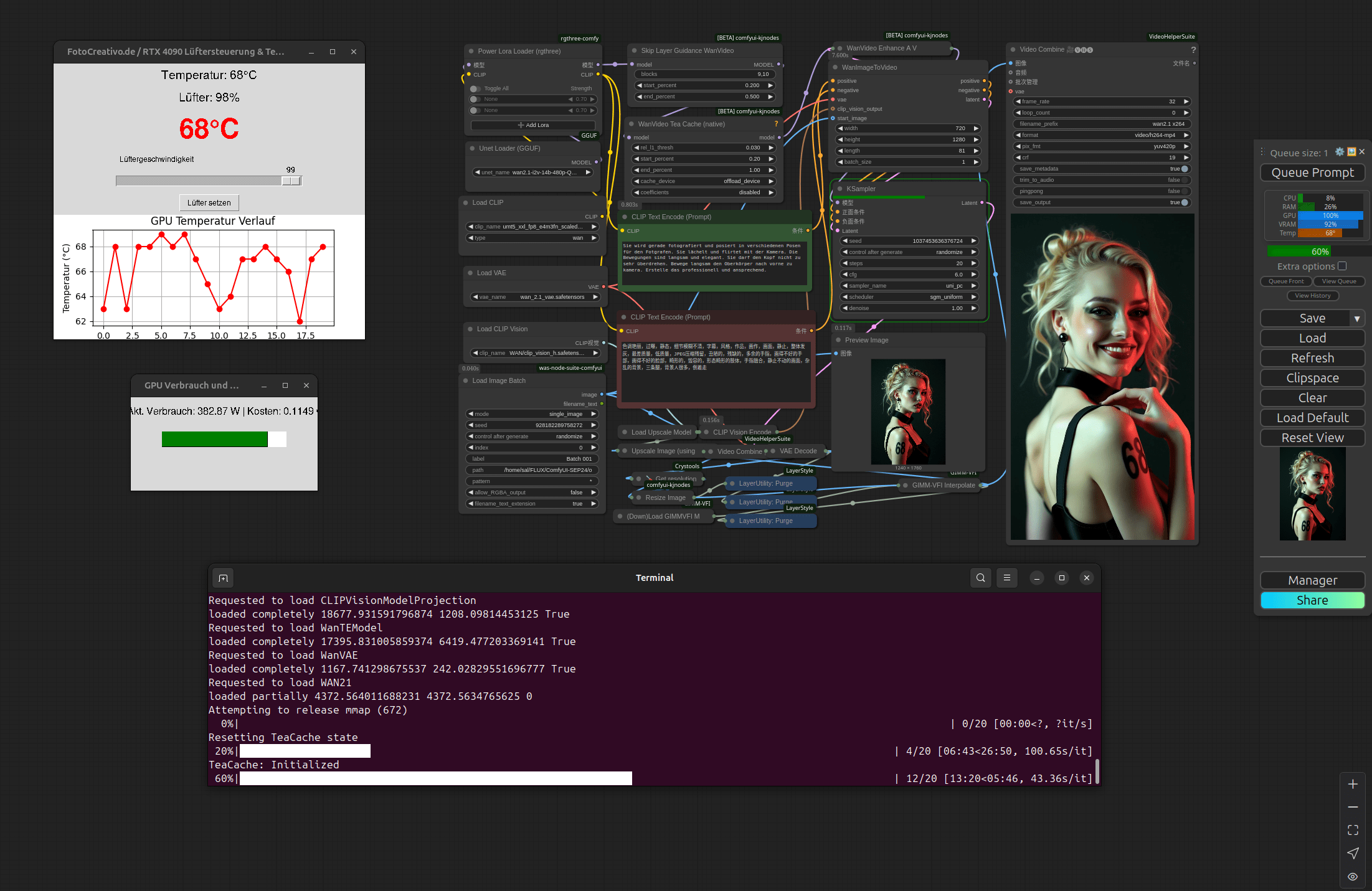

Um wirklich gezielt mit der KI zu arbeiten, reicht es nicht, ein paar Prompts einzutippen. Ich habe mir ein Setup gebaut, das mir echte Kontrolle über den Prozess gibt – sowohl technisch als auch gestalterisch. Die Berechnung von Bewegtbildern kostet enorme Rechenleistung. Deshalb habe ich unter Linux ein eigenes Tool programmiert, das mir die Temperatur meiner Grafikkarte anzeigt und eine Lüftersteuerung integriert – so kann ich unter Volllast effizient arbeiten, ohne die Hardware zu überlasten. Zusätzlich habe ich eine Anzeige zur Leistungsaufnahme, um Energieverbrauch und Kosten im Blick zu behalten. Im Zentrum steht ComfyUI – eine visuelle Umgebung, in der ich verschiedene KI-Modelle, Tools und Prozesse als sogenannte „Nodes“ miteinander verknüpfe. Diese Verknüpfungen folgen keinem Zufallsprinzip, sondern sind so gesetzt, dass sie exakt das tun, was ich von der Maschine will. Jeder Pfad, jede Verbindung, jedes Modell erfüllt dabei eine bestimmte Aufgabe. Was am Ende entsteht, ist nicht das Ergebnis von Glück – sondern von Planung, Erfahrung und einem tiefen Verständnis des Systems.

Das Ergebnis (qualitativ hier auf der Seite als GIF eingeschränkt)

5 Sekunden – 24 Minuten

Eine meiner letzten Sequenzen war gerade einmal 5 Sekunden lang – doch der Rechner hatte daran über 24 Minuten zu arbeiten. Und das war eine Version. In der höchsten Auflösung, mit optimaler Qualität.

Natürlich gibt es auch Online-Dienste, die solche Prozesse übernehmen – etwa Runway, Pika, Pollo oder ähnliche Plattformen. Diese setzen auf extrem leistungsstarke Hardware wie die NVIDIA A100 mit 80 GB RAM. Solche Karten kosten um die 30.000 Euro und liefern dementsprechend auch eine ganz andere Rechenleistung. (Faktor 5 und schneller). Doch natürlich ist auch das nicht umsonst – jede Berechnung kostet Energie, Zeit und damit Geld.

Ich selbst arbeite auf sogenannter „Consumer-Hardware“, also mit Grafikkarten, die im Preisbereich von etwa 500 bis 2000 Euro liegen. Was früher vielleicht für Gaming gedacht war, ist heute kreatives Werkzeug – allerdings mit ganz eigenen Grenzen.

Das Entscheidende ist: Wer selbst Hand anlegt, bekommt ein tiefes Gefühl für den Aufwand, der hinter einem einzigen Bild – oder eben ein paar Sekunden Video – steckt. Und das ist eben weit mehr als „einfach mal was durch die KI jagen.

Simulierte Schwerkraft

In einer meiner letzten Animationen ließ ich den Inhalt des Glas über das Gesicht des Modells „fließen“ – als wäre es versehentlich darüber geschüttet worden. Eine absurde Szene? Vielleicht. Aber technisch hochinteressant: Die Bewegung, die Lichtbrechung, der Verlauf – all das wurde von der KI nahezu physikalisch korrekt simuliert. Wie das Programm intern arbeitet, kann ich gar nicht im Detail sagen. Aber ich weiß: Früher hätte man solche Effekte in Blender manuell animieren und stundenlang rendern müssen. Heute berechnet ein neuronales Netz die Flüssigkeitssimulation in beeindruckender Geschwindigkeit – inklusive Licht, Schatten und Transparenz. Es zeigt, wie weit wir gekommen sind. Und wie sehr sich Ästhetik und Technik mittlerweile durchdringen.

(Die GIF-Animation ist stark reduziert von den Bilder/sek und der Bitrate)

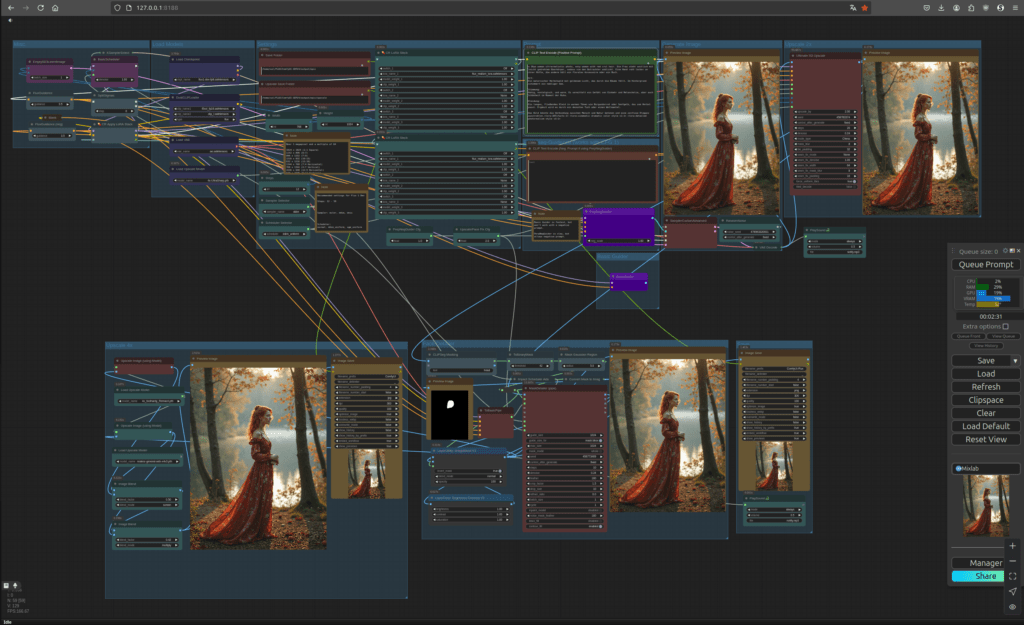

Vor einiger Zeit hatte ich ChatGPT nach einem Bild gefragt, welches ich als Nächstes erstellen soll. ChatGPT gab mir die Prompts vor und erklärte mir das folgendes Bild.

Der ganze Prozess sieht dann so aus:

Vor einpaar Tagen nutze ich das so erstellte Bild und animierte die Frau am See.

Das animierte Bild zeigt eine Frau in einem langen, eleganten roten Kleid, die in einem herbstlichen Waldstück am Ufer eines Sees steht. Das Licht fällt sanft durch die Bäume und reflektiert im Wasser – eine fast märchenhafte Stimmung entsteht. Die Figur steht leicht im Profil und scheint still in die Natur hineinzuhorchen. Die Szene wirkt ruhig, poetisch und gleichzeitig kraftvoll inszeniert. Nicht vergessen, nichts davon ist real! Der erzeugte Bild nicht und auch die Animation nicht!

Die Sequenz ist erneut auf 5 Sekunden begrenzt – das Limit setzt der Arbeitsspeicher der Grafikkarte. Eine mögliche Lösung besteht darin, das letzte Frame der ersten Animation als Ausgangspunkt für die nächste Sequenz zu verwenden – mit identischem Seed. Auf diese Weise ließen sich mehrere 5-Sekunden-Blöcke aneinanderreihen.

Allerdings ist dieser Ansatz aufwendig und nur eingeschränkt praktikabel. Ich gehe aber davon aus, dass es in den kommenden Monaten auch für dieses Problem neue, effizientere Lösungen geben wird.

Weitere Animationen folgen in Kürze – ich werde sie hier regelmäßig ergänzen.

Update Juni 2025

Ich hab mich per VPN bei Google für VEO3 angemeldet – quasi inkognito im Namen der Kreativität. Weil in Deutschland nicht verfügbar. Warum auch immer. Letzte Woche durfte ich damit ein bisschen herumspielen. Und ja, was soll ich sagen: Es sieht schon verdammt gut aus. Klar, die Animationen haben noch ein paar Schluckauf-Momente, aber das verzeiht man, wenn der Rest so glänzt. Aber jetzt kommt der Haken – und zwar ein richtig fetter: die Preispolitik. Für einen Testmonat kriegt man ganze 1000 Tokens. Klingt erstmal viel, reicht aber gerade mal für zehn Videos à 8 Sekunden. Danach heißt es: Game over, danke fürs Mitspielen. Mein Test-Account ist inzwischen wieder gelöscht – aus Prinzip. Das Coole: Ich konnte die Mini-Clips sogar auf Deutsch sprechen lassen. Hat erstaunlich gut geklappt, kein „I am a Berliner“-Cringe-Moment. Und das Beste: Das Video war in knapp zwei Minuten fertig! Zum Vergleich: Ich rendere mit meiner RTX4090 unter Linux gefühlt eine halbe Eiszeit lang – 25 Minuten für 96 Frames bei 1280×1024 Pixeln. Da weißt du, da werkelt im Hintergrund nicht irgendein Praktikant, sondern ein Server-Fuhrpark auf Steroiden.

Aber! Jetzt kommt mein persönlicher Showstopper: die Gängelung beim Prompting. Ich hab mit ChatGPT brav ein Bild beschrieben, das ich vorher mit ComfyUI gezaubert hab. Und dann? Zensur deluxe. Google reagiert auf kreative Freiheiten wie ein Beamter kurz vor Feierabend: mit Verweigerung. Und wenn man schon beim Tippen denkt, man schreibt fürs Vatikan-Archiv, dann ist für mich Schluss mit Lustig – egal wie geil die Qualität ist. Unterm Strich? Für ein bisschen Rumprobieren: nett. Für ernsthaftes Arbeiten mit künstlerischem Anspruch? Eher nein. Mein Fazit: VEO3 – toll fürs Staunen, nix fürs Ausrasten.

…